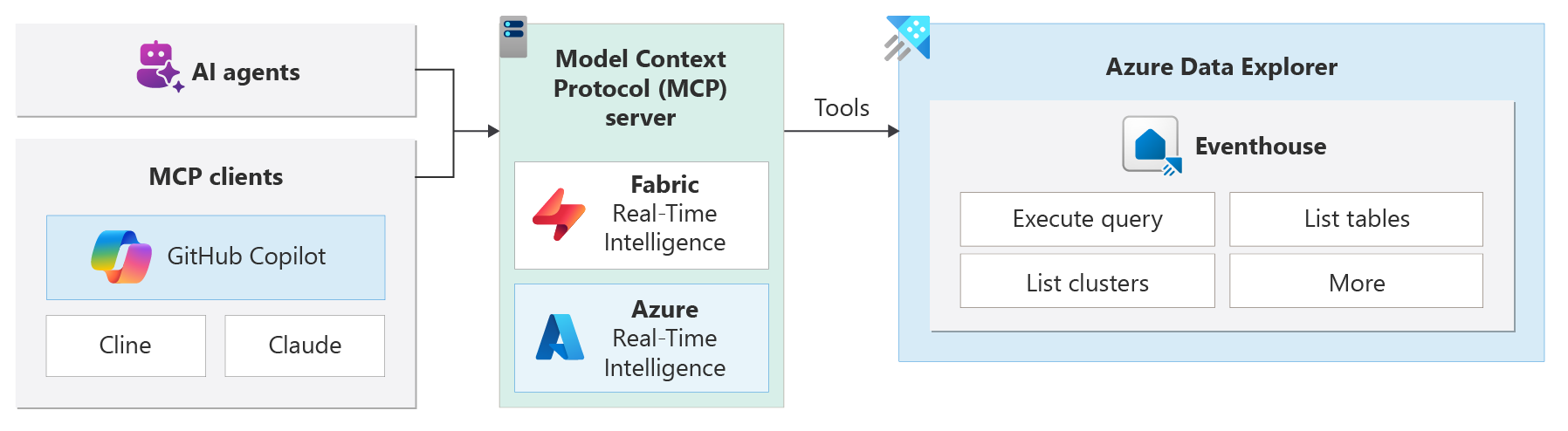

将模型上下文协议(MCP)与 Azure 数据资源管理器(ADX)群集集成,可以实时获取 AI 驱动的见解和作。 MCP 服务器通过 MCP 接口提供工具,允许 AI 代理或 AI 应用程序与 ADX 交互,以便可以轻松查询和分析数据。

模型上下文协议 (MCP)是一种协议,允许 AI 模型(如 Azure OpenAI 模型)与外部工具和资源交互。 MCP 使代理能够更轻松地查找、连接和使用企业数据。

注释

此功能处于预览状态。

使用 RTI 或 Azure MCP 服务器的最常见方案是从现有 AI 客户端(如 Cline、Claude 和 GitHub copilot)连接到它。 然后,AI 客户端可以使用可用的工具来使用自然语言访问 ADX 资源并与之交互。

例如,可以将 GitHub Copilot 代理模式与 RTI MCP 服务器配合使用来列出 KQL 数据库或在 ADX 群集上运行自然语言查询。

生成 AI 代理

MCP 对 Azure 数据资源管理器的支持是一个完整的开源 MCP 服务器集成。 它支持自然语言查询,并允许代理动态发现架构和元数据。 MCP 服务器可用于各种 AI 客户端,例如 GitHub Copilot、Cline 或 Claude Desktop。

可以使用以下 MCP 服务器将 AI 代理与 Azure 数据资源管理器集成和生成:

Fabric RTI MCP 服务器 (预览版) - 此服务器设计用于 ADX 群集或 Fabric Real-Time Intelligence (RTI) Eventhouse。 它为 AI 代理提供统一的接口,用于查询、推理和处理实时数据。

Azure MCP 服务器 (预览版) - Azure MCP 服务器允许你使用自然语言提示管理 Azure 数据资源管理器资源。 可以列出群集、查看数据库、查询数据等,而无需记住复杂的 Kusto 查询语言 (KQL) 语法。

建筑

MCP 服务器是系统的核心,充当 AI 代理和 ADX 数据源之间的桥梁。 代理将请求发送到 MCP 服务器,将请求转换为 ADX 查询。

通过此体系结构,可以构建模块化、可缩放且安全的智能应用程序,以响应实时信号。 MCP 使用客户端-服务器体系结构,因此 AI 应用程序可以有效地与外部工具进行交互。 该体系结构包括以下组件:

- MCP 主机:AI 模型运行的主机环境(如 GPT-4、Claude 或 Gemini)。

- MCP 客户端:中介服务将 AI 模型的请求转发到 MCP 服务器,如 GitHub Copilot、Cline 或 Claude Desktop。

- MCP 服务器:轻型应用程序通过自然语言 API、数据库公开特定功能。 例如,若要执行 KQL 查询,以便从 ADX 群集进行实时数据检索。

主要功能

Real-Time 数据访问:以秒为单位从 ADX 群集检索数据。

自然语言界面:用户或代理以纯英语或其他语言提问,系统将其转换为优化的查询(NL2KQL)。

架构发现:MCP 服务器显示架构和元数据,因此代理可以动态学习数据结构。

即插即用集成:由于标准化 API 和发现机制,MCP 客户端(如 GitHub Copilot、Claude 和 Cline)通过最少的设置连接到 RTI。

本地语言推理:使用首选语言处理数据。