Lakeflow Connect 提供简单高效的连接器,用于从本地文件、热门企业应用程序、数据库、云存储、消息总线等引入数据。 本页概述了 Lakeflow Connect 可提高 ETL 性能的一些方法。 它还涵盖常见用例和受支持的引入工具范围,从完全托管的连接器到完全自定义的框架。

灵活的服务模型

Lakeflow Connect 为企业应用程序、云存储、数据库、消息总线等提供了广泛的连接器。 它还使你能够灵活地在以下各项之间进行选择:

| 选项 | DESCRIPTION |

|---|---|

| 完全托管服务 | 现用连接器,使用简单的 UI 和功能强大的 API 实现数据访问的民主化。 这样,可以快速创建可靠的引入管道,同时最大程度地降低长期维护成本。 |

| 自定义管道 | 如果您需要更多的自定义选项,可以使用 Lakeflow Spark Declarative Pipelines 或 Structured Streaming。 最终,这种多功能性使 Lakeflow Connect 能够满足组织的特定需求。 |

使用核心 Databricks 工具进行统一

Lakeflow Connect 使用核心 Databricks 功能提供全面的数据管理。 例如,它通过 Unity Catalog 提供治理、通过 Lakeflow Job 提供业务流程编排,并对您的管道进行整体监控。 这有助于组织管理数据安全、质量和成本,同时将引入过程与其他数据工程工具统一。 Lakeflow Connect 基于开放式数据智能平台构建,可以完全灵活地整合首选的第三方工具。 这可确保定制解决方案与现有基础结构和未来的数据策略保持一致。

快速、可扩展的摄取

Lakeflow Connect 使用增量读取和写入来实现高效的引入。 当与下游增量转换结合使用时,这可以显著提高 ETL 性能。

常见用例

客户引入数据以解决其组织最具挑战性的问题。 示例用例包括:

| 用例 | DESCRIPTION |

|---|---|

| 客户 360 | 衡量营销活动绩效和潜在客户评分 |

| 项目组合管理 | 通过历史模型和预测模型最大化 ROI |

| 使用者分析 | 个性化客户的购买体验 |

| 集中人力资源 | 支持您的组织的员工队伍 |

| 数字孪生体 | 提高制造效率 |

| RAG 聊天机器人 | 构建聊天机器人以帮助用户了解策略、产品等 |

ETL 堆栈各层

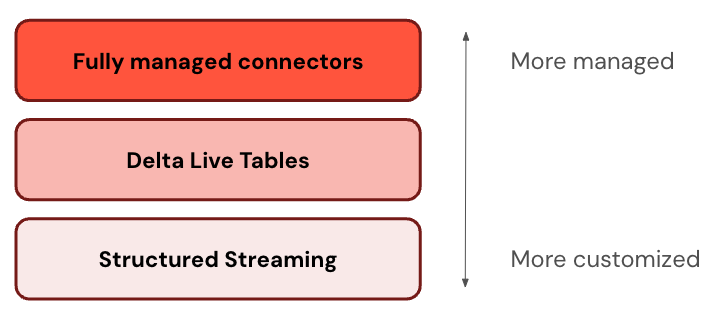

某些连接器在 ETL 堆栈的一个级别运行。 例如,Databricks 为 Salesforce 等企业应用程序提供完全托管的连接器,以及 SQL Server 等数据库。 其他连接器在 ETL 堆栈的多层上运行。 例如,你可以在结构化流中使用标准连接器以实现完全自定义,或者使用 Lakeflow Spark 声明性管道来获得更便捷的托管体验。 同样,可以选择用于从 Apache Kafka、Amazon Kinesis 和 Apache Pulsar 流式传输数据的自定义级别。

Databricks 建议从最托管层开始。 如果它不满足你的要求(例如,如果它不支持数据源),请下拉到下一层。 Databricks 计划扩展对所有三个层的更多连接器的支持。

下表描述了从最可自定义到最托管的引入产品的三个层:

| 层 | DESCRIPTION |

|---|---|

| 结构化数据流 | 结构化流式处理是一个 API,用于近乎实时地进行增量流处理。 它提供强大的性能、可伸缩性和容错能力。 |

| Lakeflow Spark 声明式管道 | Lakeflow Spark 声明性管道基于结构化流式处理构建,提供用于创建数据管道的声明性框架。 可以定义要对数据执行的转换,Lakeflow Spark 声明性管道管理业务流程、监视、数据质量、错误等。 因此,它提供比结构化流式处理更多的自动化和更少的开销。 |

标准连接器

除了托管连接器,Databricks 还提供云对象存储和消息总线的可自定义连接器。 请参阅 Lakeflow Connect 中的标准连接器。

文件上传和下载

可以引入驻留在本地网络上的文件、已上传到卷的文件或从 Internet 位置下载的文件。 请参阅 文件。

DIY 引入

Databricks 提供一个常规计算平台。 因此,可以使用 Databricks 支持的任何编程语言(如 Python 或 Java)创建自己的引入连接器。 还可以导入和使用常用的开源连接器库,例如数据加载工具、Airbyte 和 Debezium。

引入替代项

Databricks 建议引入大多数用例,因为它可缩放以适应数据量大、低延迟查询和第三方 API 限制。 引入将数据从源系统复制到 Azure Databricks,这会导致一段时间内可能过时的数据重复。 如果不想复制数据,可以使用以下工具:

| Tool | DESCRIPTION |

|---|---|

| Lakehouse 联合身份验证 | 允许在不移动数据的情况下查询外部数据源。 |

| Delta共享 | 允许跨平台、云和区域安全地共享数据。 |