本部分介绍如何在 Azure Databricks 用户界面中使用 Lakeflow Spark 声明性管道的内置监视和可观测性功能。 这些功能支持以下任务:

- 观察管道更新的进度和状态。 请参阅 监视页中可用的管道详细信息。

- 对管道事件发出警报,例如管道更新的成功或失败。 请参阅 为管道事件添加电子邮件通知。

- 查看 Apache Kafka 和自动加载程序(公共预览版)等流式处理源的指标。 请参阅查看流式处理指标。

为管道事件添加电子邮件通知

可在出现以下情况时配置一个或多个电子邮件地址来接收通知:

- 管道更新成功完成。

- 管道更新失败,出现可重试或不可重试错误。 选择此选项将接收有关所有管道故障的通知。

- 管道更新失败并出现不可重试(致命)错误。 选择此选项将仅在发生不可重试错误时接收通知。

- 单个数据流失败。

若要配置电子邮件通知,请编辑管道的设置。 请参阅 通知。

注释

使用 Python 事件挂钩创建自定义响应,包括通知或自定义处理。

在 UI 中查看管道

从开始,在工作区边栏中的“作业和流水线”选项查找你的管道。 这会打开 “作业和管道 ”页,可在其中查看有关你有权访问的每个作业和管道的信息。 单击管道的名称以打开管道监视页。 若要编辑作业或管道,请单击

菜单,然后选择“ 编辑”。

注释

作业和不同的管道类型具有不同的编辑器。 “ 编辑” 选项将打开所选对象的正确编辑器。

如何使用作业和管道列表

若要查看您有权访问的管道列表,请单击边栏中的,然后选择作业和管道。 “ 作业和管道 ”选项卡列出了有关所有可用作业和管道的信息,例如创建者、触发器(如果有),以及最后五次运行的结果。

单击管道或作业的名称会将你转到该管道或作业的监视页。 若要编辑管道或作业,请单击 然后选择“ 编辑”。

若要更改列表中显示的列,请单击“ 并选择或取消选择列。 例如,若要将

Pipeline Type 添加为列,请选择要添加的列。

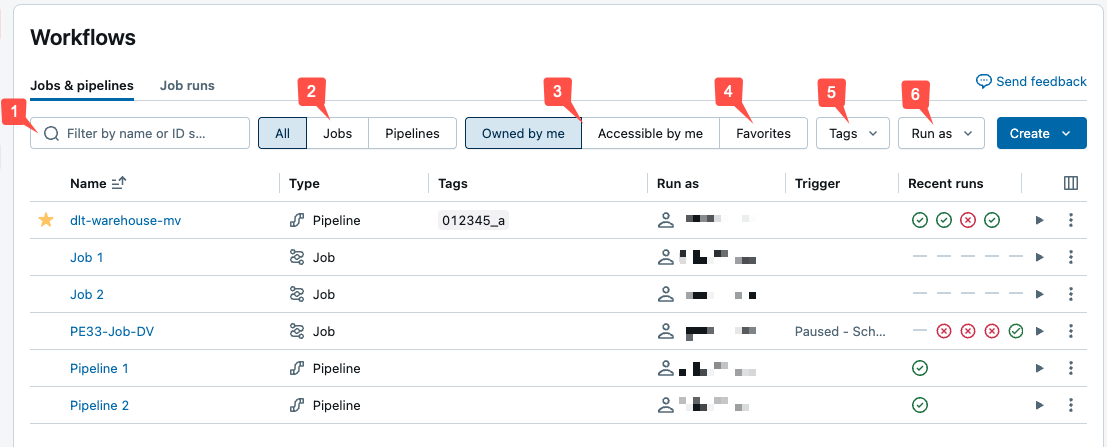

可以在 “作业和管道 ”列表中筛选作业,如以下屏幕截图所示。

文本搜索: 名称和ID 字段支持关键字搜索。 若要搜索使用键和值创建的标记,可以按键、值或键和值进行搜索。 例如,对于具有键

department和值finance的标记,可以搜索department或finance查找匹配的作业。 若要按键和值进行搜索,请输入用冒号分隔的键和值(例如,department:finance)。类型:按 作业、 管道或 全部筛选。 如果选择 “管道” ,还可以按 管道类型进行筛选,其中包括 ETL 和引入管道。

所有者:仅显示你拥有的作业。

收藏夹:显示已标记为收藏的作业。

标签:使用 标签。 若要按标记进行搜索,可以使用标记下拉菜单同时筛选最多五个标记,或者直接使用关键字搜索。

运行方式:最多按两

run as个值进行筛选。

若要启动作业或管道,请单击 播放按钮。 若要停止作业或管道,请单击

按钮。 若要访问其他操作,请单击烤肉串菜单图标

例如,可以编辑或删除作业或管道,或者从该菜单中访问管道的设置。

监视页中提供的管道详细信息

注释

有多个预览会影响您在 UI 中监视管道时看到的内容。

- Lakeflow 管道编辑器更改管道详细信息的体验。 如果选择预览版,信息会显示在不同于此处所述的 UI 中。 有关该 UI 的详细信息,请参阅 Lakeflow 管道编辑器中的哪些更改?

- 统一运行列表预览功能将流水线运行添加到作业运行列表中。 有关启用该预览后的更改详情以及如何启用的方法,请参阅统一运行列表预览的详细信息。

单击 Jobs & Pipelines 页中的管道名称会显示该管道的监控页面。 从这里可以启动管道运行,并查看以前的运行详细信息。

管道图(也称为 DAG)在成功启动管道更新后立即显示。 箭头表示管道中数据集之间的依赖关系。 默认情况下,管道监视页显示表的最新更新,但可以从下拉菜单中选择较旧的更新。

详细信息包括管道 ID、源代码、计算成本、产品版本、为管道配置的通道。

若要查看数据集的表格视图,请单击“ 列表 ”选项卡。“ 列表” 视图允许查看管道中的所有数据集,这些数据集表示为表中的行,并且当管道图太大而无法显示在 图形 视图中时非常有用。 可以使用多个筛选器(如数据集名称、类型和状态)来控制表中显示的数据集。 要切换回 DAG 可视化效果,请点击“Graph”。

“运行身份”用户是管道所有者,管道更新使用此用户的权限运行。 若要更改 run as 用户,请单击“权限”并更改管道所有者。

Lakeflow Pipelines 编辑器有哪些变化?

如果选择进入 Lakeflow 管道编辑器预览版和新的管道监视 UI,则 UI 中的某些信息位于不同位置。 有关 Lakeflow 管道编辑器的信息以及如何选择加入这两个预览,请参阅 启用 Lakeflow 管道编辑器和更新的监视。

重要

此功能目前以公共预览版提供。 可以在预览页面上确认加入状态。 请参阅 管理 Azure Databricks 预览版。

当选择加入这两个预览版时,管道监视页上的监视功能将出现以下更改:

右侧面板中的 “管道详细信息 ”和“ 更新详细信息 ”选项卡已与顶部的管道详细信息合并,后跟更新详细信息。

单击图形中的表格不会在右侧面板中显示表详细信息。 右侧面板继续显示流水线和更新的详细信息。 相反,底部面板显示表信息。

在开发模式下运行管道的规则会稍有更新。 有关开发模式的信息,请参阅 开发模式。

- 通过计划或触发器运行管道时,其是否使用开发模式由管道设置决定。 可以在 管道设置中更改管道的默认值。

- 通过监视 UI 运行管道将使用管道设置中定义的模式。 可以通过下拉菜单中的以不同设置运行选项来选择是否使用开发模式。

- 从管道编辑器运行管道将默认为开发模式。 可以选择不使用开发模式,方法是使用下拉列表中的使用不同设置运行选项。

管道详细信息中不再有指向源代码的链接。 而是选择顶部的 “编辑管道 ”。 若要跳转到特定表的代码,请将鼠标悬停在 DAG 中的表上,然后单击

导航到代码 按钮。

默认情况下,在管道监视页的每个更新上不再显示事件日志。 在处理过程中出错时,错误将显示在底部面板中,并显示 “查看日志 ”按钮以查看该运行的事件日志。 还可以通过选择

来访问事件日志。从右侧面板中的运行详细信息查看事件日志。

若要在新的 Lakeflow 管道编辑器中运行更新时访问事件日志,请导航到编辑器底部的 问题和见解 面板,单击 查看日志,或单击任何错误旁边的 打开日志 按钮。 有关详细信息,请参阅 Lakeflow 管道编辑器 和 事件日志的管道设置。

可以通过选择底部面板的“ 表 ”选项卡中的表,然后选择 “列”来获取表架构信息。

可以通过在底部面板中选择 “性能 ”来获取查询历史记录。

管道详细信息页中不提供表注释。 若要查看表注释,请从目录资源管理器查看表。 若要直接跳转到目录资源管理器中的表,请将鼠标悬停在 DAG 中的表上,然后单击

然后单击

在目录中查看。 还可以通过单击

从底部面板中的表列表中访问目录资源管理器中的信息。

统一运行列表预览版中的哪些更改?

如果已启用 统一运行列表 预览版,可以在 “作业和管道 ”页中看到管道运行更新。

若要访问统一运行列表,请选择“ 从工作区边栏运行,或单击

作业和管道,然后选择“ 运行 ”选项卡。

该选项卡显示过去 60 天内最近运行的列表。 显示过去 48 小时内运行成功和失败的图形首先显示在以下情况下:

- 过滤至仅 作业 或 管道。

- 你是管理员,或筛选为仅运行

Run as: Me - 运行结果可能最多需要一小时才能显示在图表上。

可以通过以下方式筛选列表和图形:

- 作业或管道的名称。

- 所有、 任务或 流水线。

- 管道类型 (ETL、引入、MV/ST 或数据库表同步)。

- 以用户身份运行。

- 运行 开始时间 (在过去 48 小时内)。

- 运行状态。

- 失败运行的 错误代码 。

除了上述列,还可以在列表中查看以下列:

- 结束时间

- 运行 ID

- 运行是手动启动还是按计划 启动 。

- 运行 Duration。

- 运行参数。

若要更改运行列表中显示的列,请单击,然后选择或取消选择需要显示的列。

单击管道运行的 开始时间、 结束时间或 名称 会将你转到管道的 监视页 。

当管道处于主动运行状态时,可以通过单击“ 停止运行。停止按钮。 您可以随时单击运行行上的

菜单按钮,然后选择编辑管道以在编辑器中查看管道。

如何查看数据集详细信息?

单击管道图或数据集列表中的数据集会显示有关数据集的详细信息。 详细信息包括数据集架构、数据质量指标以及定义数据集的源代码的链接。

看更新历史记录

若要查看管道更新的历史记录和状态,请单击顶部栏中的“更新历史记录”下拉菜单。

在下拉菜单中选择更新,以查看更新的图、详细信息和事件。 若要返回到最新更新,请单击“显示最新更新”。

查看流式处理指标

重要

管道的流媒体可观测性处于公开预览。

可以从 Spark 结构化流支持的数据源(如 Apache Kafka、Amazon Kinesis、自动加载器和 Delta 表)查看管道中每个流式处理流的流指标。 指标在管道 UI 的右窗格中显示为图表,包括积压工作秒、积压工作字节数、积压工作记录和积压工作文件。 图表显示按分钟聚合的最大值,当将鼠标悬停在图表上时,工具提示会显示相应的最大值。 数据限制为从当前时间开始的最后 48 小时。

在 UI ![]() LDP Chart Icon图形视图中查看管道 DAG 时,管道中具有流式处理指标的表会显示 图标。 若要查看流式处理指标,请单击

LDP Chart Icon图形视图中查看管道 DAG 时,管道中具有流式处理指标的表会显示 图标。 若要查看流式处理指标,请单击 ![]() ,在右窗格中的“ 流 ”选项卡中显示流式处理指标图表。 还可以应用筛选器来仅查看具有流式处理指标的表,方法是单击 列表,然后单击 “具有流式处理指标”。

,在右窗格中的“ 流 ”选项卡中显示流式处理指标图表。 还可以应用筛选器来仅查看具有流式处理指标的表,方法是单击 列表,然后单击 “具有流式处理指标”。

每个流媒体源仅支持特定指标。 流式处理源不支持的指标在 UI 中无法查看。 下表显示了可用于所支持的流媒体源的度量标准:

| 源 | 积压字节 | 积压记录 | 积压工作秒数 | 积压工作文件 |

|---|---|---|---|---|

| Kafka | ✓ | ✓ | ||

| 动动力 | ✓ | ✓ | ||

| Delta | ✓ | ✓ | ||

| 自动加载器 | ✓ | ✓ |