示例笔记本

该示例笔记本使用 PyTorch 运行单个深度学习模型训练作业,该作业作为 MLflow 运行进行跟踪。 它记录每 10 个时期之后的检查点模型。 每个检查点作为 MLflow LoggedModel 进行跟踪。 使用 MLflow 的 UI 或搜索 API,可以检查检查点模型并按准确性对其进行排名。

笔记本安装 scikit-learn 和 torch 库。

使用检查点笔记本的 MLflow 3 深度学习模型

使用 UI 浏览模型性能并注册模型

运行笔记本后,可以在 MLflow 试验 UI 中查看保存的检查点模型。 指向试验的链接显示在笔记本单元格输出中,或按照以下步骤操作:

单击工作区边栏中的 “试验 ”。

在实验列表中查找您的实验。 可以选择“ 仅我的试验 ”复选框,或使用 “筛选试验 ”搜索框筛选试验列表。

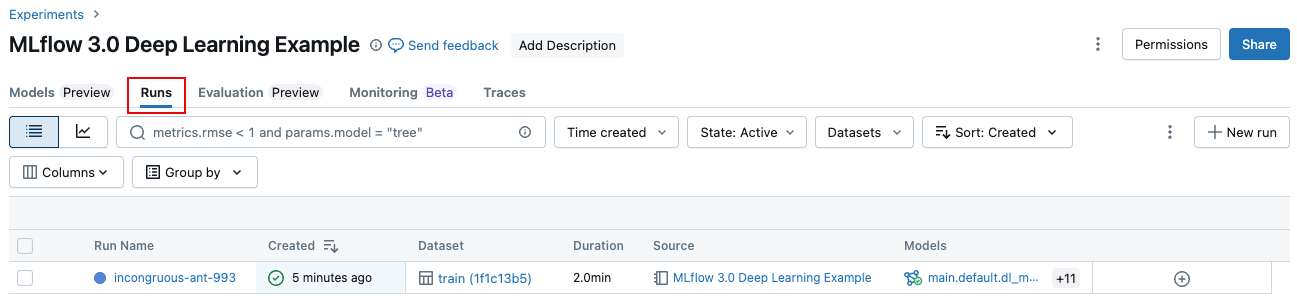

单击试验的名称。 此时会打开 “运行” 页。 试验包含一个 MLflow 运行。

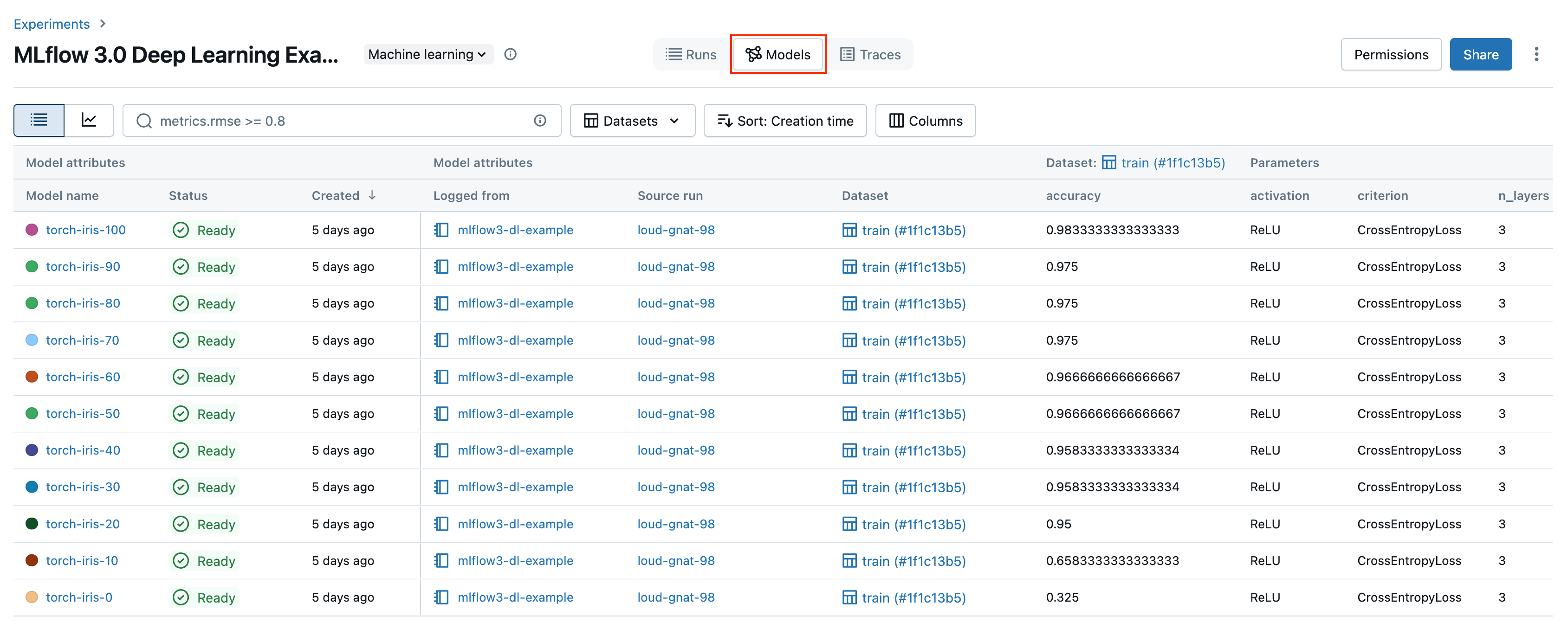

单击“模型”选项卡。在此屏幕上跟踪各个检查点模型。 对于每个检查点,可以看到模型的准确性及其所有参数和元数据。

在示例笔记本中,你向 Unity 目录注册了性能最佳的模型。 还可以从 UI 注册模型。 为此,请执行以下步骤:

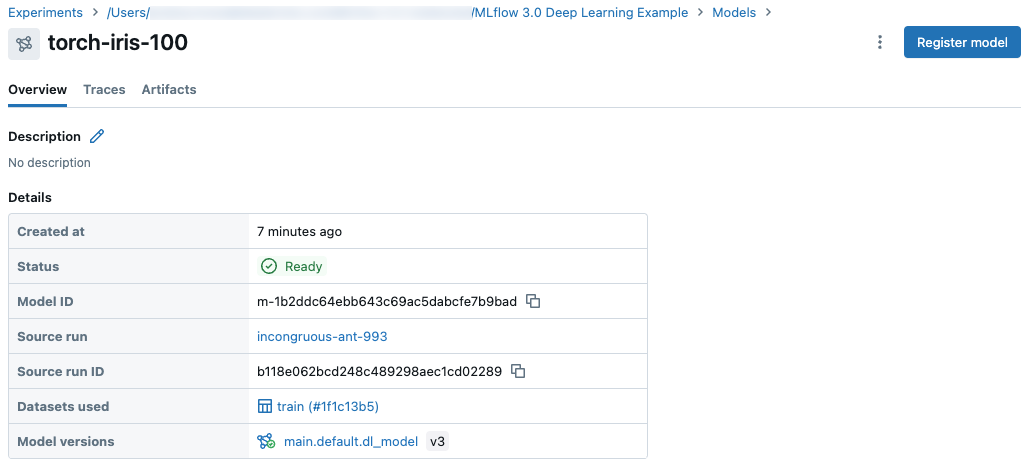

在“ 模型 ”选项卡中,单击要注册的模型的名称。

在模型详细信息页的右上角,单击“ 注册模型”。

小窍门

注册模型后,模型可能需要几分钟才会显示在 UI 中。 不要多次按 Register 模型 ,否则将注册重复的模型。

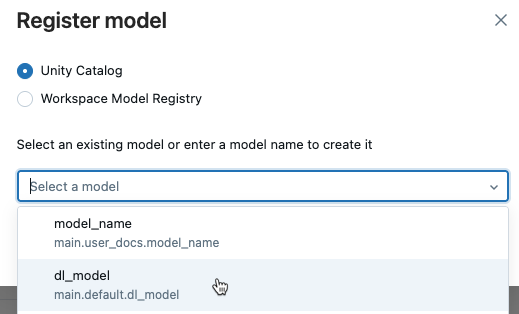

选择 Unity 目录 ,然后从下拉菜单中选择现有模型名称,或键入新名称。

单击“注册”。

使用 API 对检查点模型进行排名

以下代码演示如何按准确性对检查点模型进行排名。 有关使用 API 搜索记录的模型的详细信息,请参阅 “搜索”和“筛选记录的模型”。

ranked_checkpoints = mlflow.search_logged_models(

output_format="list",

order_by=[{"field_name": "metrics.accuracy", "ascending": False}]

)

best_checkpoint: mlflow.entities.LoggedModel = ranked_checkpoints[0]

print(best_checkpoint.metrics[0])

<Metric:

dataset_digest='9951783d',

dataset_name='train',

key='accuracy',

model_id='m-bba8fa52b6a6499281c43ef17fcdac84',

run_id='394928abe6fc4787aaf4e666ac89dc8a',

step=90,

timestamp=1730828771880,

value=0.9553571428571429

>

worst_checkpoint: mlflow.entities.LoggedModel = ranked_checkpoints[-1]

print(worst_checkpoint.metrics[0])

<Metric:

dataset_digest='9951783d',

dataset_name='train',

key='accuracy',

model_id='m-88885bc26de7492f908069cfe15a1499',

run_id='394928abe6fc4787aaf4e666ac89dc8a',

step=0,

timestamp=1730828730040,

value=0.35714285714285715

MLflow 试验页上的 “模型 ”选项卡和目录资源管理器中的“模型版本”页有何区别?

“试验”页的“模型”选项卡和目录资源管理器中的“模型版本”页显示有关模型的类似信息。 这两个视图在模型开发和部署生命周期中具有不同的角色。

- 试验页的“ 模型 ”选项卡显示单个页面上试验中记录的模型的结果。 此页上的 “图表”选项卡 提供了可视化效果,可帮助你比较模型,并选择模型版本以注册到 Unity 目录,以便进行可能的部署。

- 在目录资源管理器中,模型版本页概述了所有模型性能和评估结果。 本页显示所有链接环境(包括不同工作区、终结点和试验)的模型参数、指标和跟踪。 这对于监视和部署非常有用,尤其适用于 部署作业。 部署作业中的评估任务将创建此页上显示的其他指标。 然后,任务的审批人可以查看此页面,以评估是否批准模型版本进行部署。

后续步骤

若要了解有关 MLflow 3 中引入的跟踪的详细信息 LoggedModel ,请参阅以下文章:

若要详细了解如何将 MLflow 3 与传统 ML 工作流配合使用,请参阅以下文章: