Nota:

El acceso a esta página requiere autorización. Puede intentar iniciar sesión o cambiar directorios.

El acceso a esta página requiere autorización. Puede intentar cambiar los directorios.

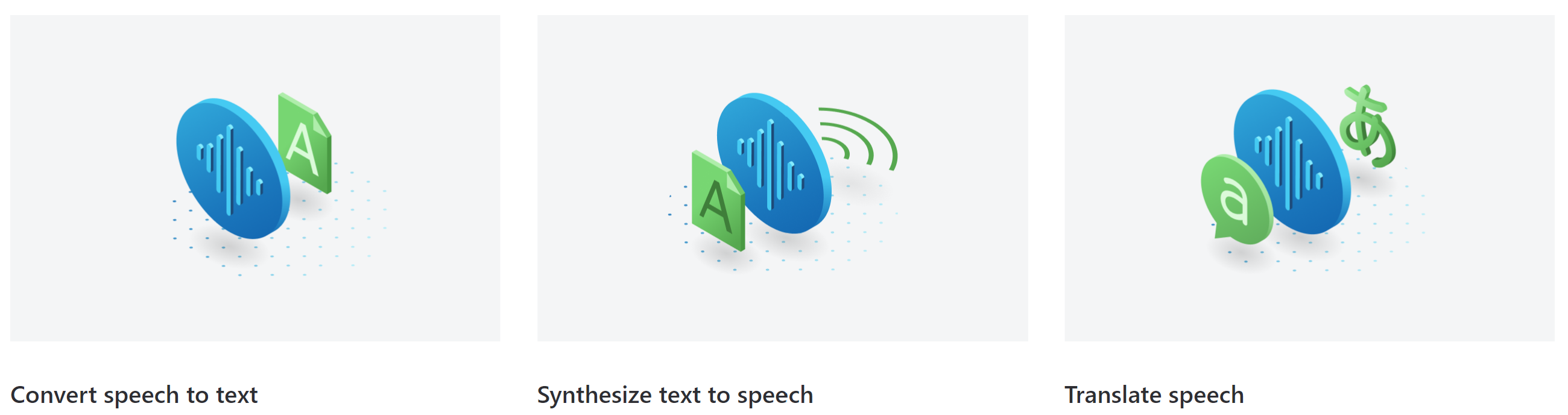

语音服务通过 语音资源提供语音转文本和文本转语音功能。 你可以将语音转录为准确度较高的文本、生成自然语音转语音、翻译语音和进行实时 AI 语音对话。

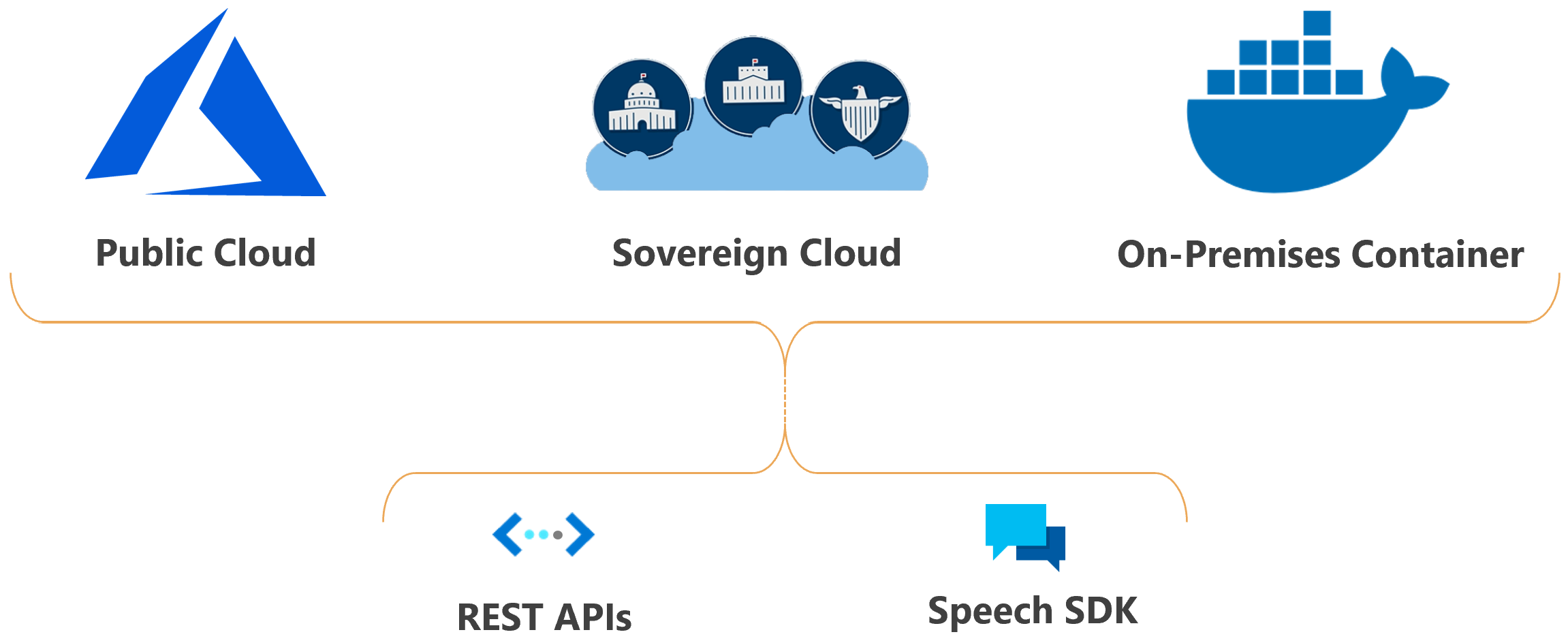

在任意位置(云中或容器的边缘)运行语音。 使用 Speech CLI、Speech SDK 和 REST APIs 可以轻松启用应用程序、工具和设备的语音功能。

语音方案

语音的常见方案包括:

- 字幕:了解如何将字幕与输入音频同步、应用亵渎内容过滤器、获得部分结果、应用自定义以及识别多语言场景的口语。

- 音频内容创建:使用神经语音使与聊天机器人和语音代理的交互更加自然和引人入胜,将电子书等数字文本转换为音录,以及增强汽车内导航系统。

- 呼叫中心:实时转录呼叫或处理一批呼叫,对个人身份信息进行修订,并提取情绪等见解,以帮助处理呼叫中心用例。

- 语言学习:向语言学习者提供发音评估反馈,支持远程学习对话的实时听录,并使用神经语音大声朗读教材。

- 语音直播:为应用程序和体验创建自然的、像对话界面这样的人。 语音直播功能在人与代理实现之间提供快速、可靠的交互。

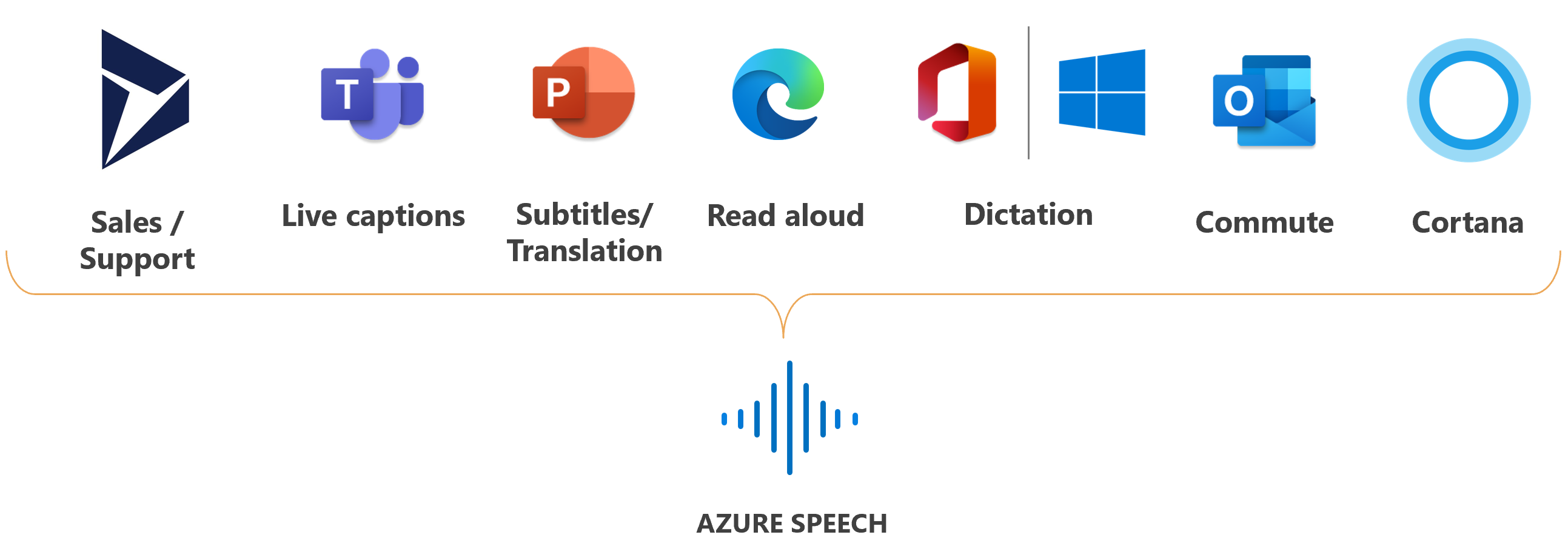

Microsoft 将语音用于许多方案中,例如 Teams 中的字幕、Office 365 中的听写,以及 Microsoft Edge 浏览器中的大声朗读功能。

语音功能

这些部分对语音功能进行了汇总,并提供导向详细信息的链接。

语音转文本

使用 语音转文本 将音频转换为文本。 从流式处理音频的 实时听录 、预录制音频文件的 快速听录 或 批量听录 中进行选择,以便异步处理大量音频。

如果音频包含环境噪声或大量行业和特定领域的术语,则基础模型可能不够用。 在这些情况下,可以使用声学、语言和发音数据创建和训练自定义语音识别模型。 自定义语音识别模型是专用的,具有竞争优势。

文本转语音

使用 文本转语音,可以将输入文本转换为类似人工合成的语音。 使用神经语音,这是由深度神经网络提供支持的类似人类的声音。 使用语音合成标记语言 (SSML) 来微调音节、发音、语速、音量等特征。

- 标准语音:很自然的现成语音。 请查看Voice Gallery中的标准语音示例,并确定适合您业务需求的语音。

语音翻译

使用语音翻译可在应用程序、工具和设备中实现实时的多语言语音翻译。 实施语音转语音和语音转文本翻译时可以使用此功能。

语言识别

语言识别功能通过与受支持的语言列表进行比较,识别音频中讲的语言。 借助语音转文本识别或语音翻译,让语言自身识别语言。

发音评估

发音评估可以评估语音发音,并为说话人提供有关讲话音频准确度和流利度的反馈。 通过使用发音评估,语言学习者可以练习、获取即时反馈并改进发音,以便他们可以自信地说话和呈现。

交付和存在

可以在云中部署 Azure 语音功能。

主权云中的语音服务部署适用于某些政府实体及其合作伙伴。 例如,由世纪互联运营的 Microsoft Azure 可供在中国开展业务的组织使用。 有关详细信息,请参阅主权云。

在应用程序中使用语音

Speech Studio 是一组基于 UI 的工具,用于在应用程序中生成和集成 Azure 语音服务中的功能。 通过使用无代码方法在 Speech Studio 中创建项目,然后通过使用语音 SDK、语音 CLI 或 REST API 来引用应用程序中的资产。

语音 CLI 是一种命令行工具,用于在不编写任何代码的情况下使用语音服务。 语音 SDK 中的大部分功能都可在语音 CLI 中使用,一些高级功能和自定义设置在语音 CLI 中进行了简化。

语音 SDK 公开了许多语音服务功能,这些功能可用于开发支持语音的应用程序。 语音 SDK 可以在许多编程语言中和所有平台中使用。

在某些情况下,不能或不应使用语音 SDK。 在这些情况下,可以使用 REST API 访问语音服务。 例如,使用 REST API 进行批量听录。

开始

我们提供许多常用编程语言的快速入门。 每个快速入门旨在让你了解基本设计模式并帮助你在 10 分钟以内运行代码。 请参阅以下列表,了解每项功能的快速入门:

代码示例

GitHub 上提供了语音服务的示例代码。 这些示例涵盖了常见方案,例如,从文件或流中读取音频、连续和单次识别,以及使用自定义模型。 使用以下链接查看 SDK 和 REST 示例: