注释

此页面使用策略定义的 JSON 示例。 新策略表单使用下拉菜单和其他 UI 元素模糊处理大多数 JSON 策略定义。 策略规则和逻辑仍然相同,但用户无需编写 JSON 代码即可配置定义。 如果不想使用新窗体,则可以在策略页面顶部关闭 “新建窗体 ”设置。

此页面是计算策略定义的参考,包括可用策略属性和限制类型的列表。 还有可以参考常见用例的示例策略。

什么是策略定义?

策略定义是用 JSON 表示的单个策略规则。

定义可以将规则添加到使用群集 API 控制的任何属性。 例如,这些定义设置默认的自动终止时间,禁止用户使用池,并强制使用 Photon:

{

"autotermination_minutes": {

"type": "unlimited",

"defaultValue": 4320,

"isOptional": true

},

"instance_pool_id": {

"type": "forbidden",

"hidden": true

},

"runtime_engine": {

"type": "fixed",

"value": "PHOTON",

"hidden": true

}

}

每个属性只能有一个限制。 属性的路径反映 API 属性名称。 对于嵌套属性,路径使用点来连接嵌套属性名称。 策略定义中未定义的属性不会受到限制。

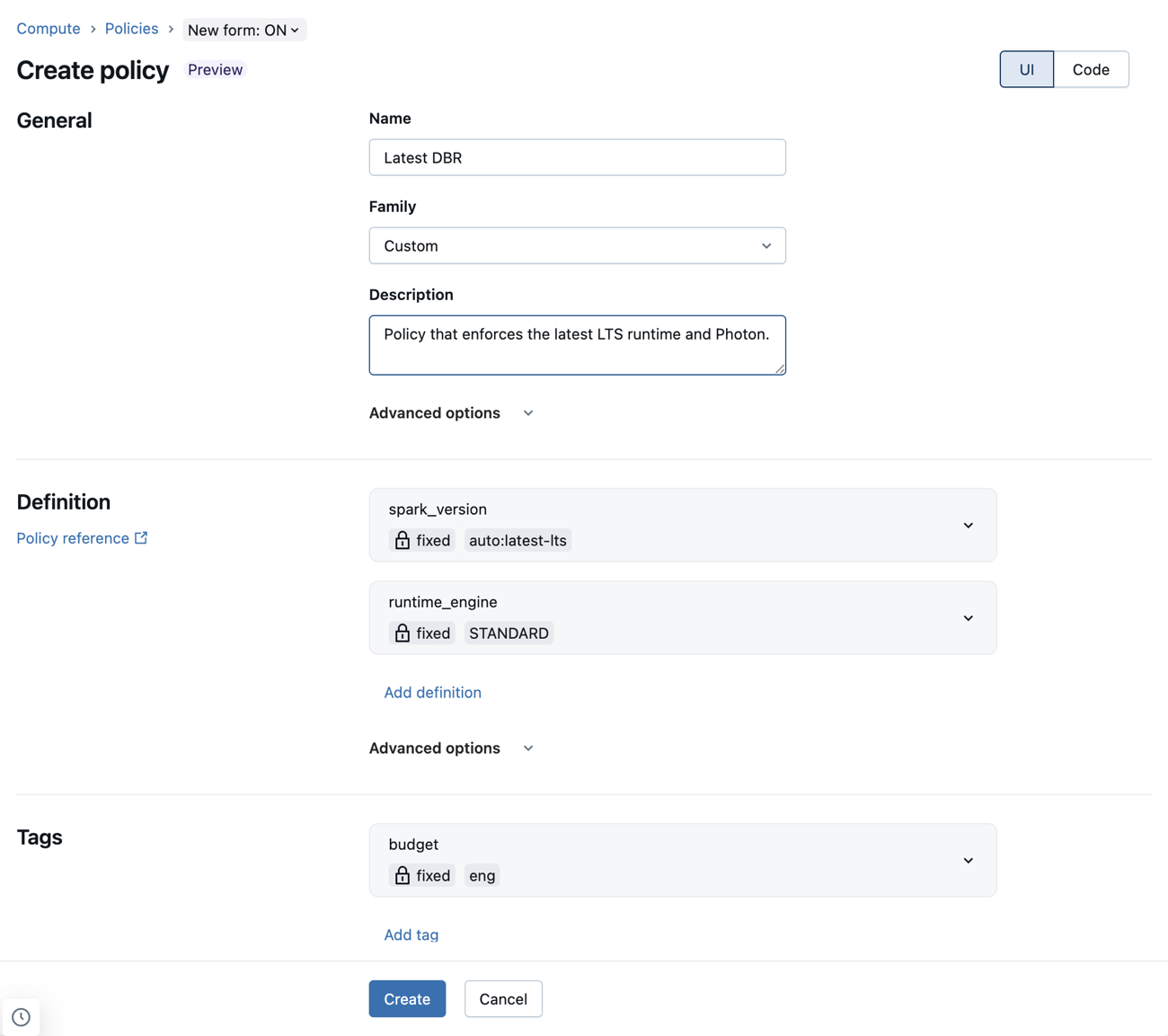

使用新策略表单配置策略定义

使用新策略窗体,可以使用下拉菜单和其他 UI 元素配置策略定义。 这意味着管理员可以编写策略,而无需了解或引用策略语法。

新窗体中仍支持 JSON 策略定义。 这些属性可以添加到“高级”选项下的“自定义 JSON”字段。

使用新策略窗体的已知限制

如果新计算策略表单不支持某个策略,则任何不兼容的定义将显示在 “高级选项 ”部分中的自定义 JSON 字段中。 对于以下字段,仅支持一部分有效策略:

-

workload_type:策略必须同时定义

workload_type.clients.notebooks和workload_type.clients.jobs。 这些规则中的每一个都必须固定为或truefalse。 -

dbus_per_hour:仅支持指定

maxValue和未指定minValue的范围策略。 -

ssh_public_keys:仅支持固定策略。 策略

ssh_public_keys不得跳过任何索引。 例如,是ssh_public_keys.0ssh_public_keys.1ssh_public_keys.2有效的,但ssh_public_keys.0ssh_public_keys.2ssh_public_keys.3无效。 -

cluster_log_conf:不能

cluster_log_conf.path是允许列表或阻止列表。 -

init_scripts:索引策略(即)

init_scripts.0.volumes.destination必须修复。 必须禁止通配符策略(即init_scripts.*.volumes.destination) 索引策略不得跳过任何索引。

支持的属性

策略支持使用群集 API控制的所有属性。 可以针对属性设置的限制类型可能因其类型和与 UI 元素的关系而异。 不能使用策略来定义计算权限。

还可以使用策略设置每小时的最大 DBU 数和群集类型。 请参阅虚拟属性路径。

下表列出了支持的策略属性路径:

| 属性路径 | 类型 | DESCRIPTION |

|---|---|---|

autoscale.max_workers |

可选数值 | 隐藏后,从 UI 中删除“最大辅助角色数目”字段。 |

autoscale.min_workers |

可选数值 | 隐藏后,从 UI 中删除“最小辅助角色数目”字段。 |

autotermination_minutes |

数字 | 值 0 表示没有自动终止。 隐藏后,从 UI 中删除自动终止复选框和值输入。 |

azure_attributes.availability |

字符串 | 控制计算使用情况是使用按需实例还是现成实例(SPOT_AZURE或ON_DEMAND_AZURESPOT_WITH_FALLBACK_AZURE)。 |

azure_attributes.first_on_demand |

数字 | 控制从驱动程序节点开始群集节点使用的按需实例数量。 例如,1 的值将驱动程序节点设置为按需节点。

2 的值将驱动节点和一个工作器节点设为按需节点。 |

azure_attributes.spot_bid_max_price |

数字 | 控制 Azure 现成实例的最高价格。 |

cluster_log_conf.path |

字符串 | 日志文件的目标 URL。 |

cluster_log_conf.type |

字符串 | 日志目标的类型。

DBFS 和 VOLUMES 是仅有的可接受值。 |

cluster_name |

字符串 | 群集名称。 |

custom_tags.* |

字符串 | 通过追加标记名来控制特定的标记值,例如:custom_tags.<mytag>。 |

data_security_mode |

字符串 | 设置群集的访问模式。 Unity 目录需要 SINGLE_USER 或 USER_ISOLATION (UI 中的标准 访问模式)。

NONE 值意味着未启用任何安全功能。 |

docker_image.basic_auth.password |

字符串 | 用于 Databricks 容器服务映像基本身份验证的密码。 |

docker_image.basic_auth.username |

字符串 | 用于 Databricks 容器服务映像基本身份验证的用户名。 |

docker_image.url |

字符串 | 控制 Databricks 容器服务映像 URL。 隐藏后,从 UI 中删除“Databricks 容器服务”部分。 |

driver_node_type_id |

可选字符串 | 隐藏后,从 UI 中删除驱动器节点类型选择。 |

driver_node_type_flexibility.alternate_node_type_ids |

字符串 | 指定驱动程序节点的备用节点类型。 仅支持固定策略。 请参阅 灵活节点类型。 |

enable_local_disk_encryption |

布尔 | 设置为 true 以启用,或设置为 false 禁用对本地附加到群集的磁盘进行加密(通过 API 指定)。 |

init_scripts.*.workspace.destination

init_scripts.*.volumes.destination

init_scripts.*.abfss.destination

init_scripts.*.file.destination

|

字符串 |

* 是指属性数组中初始化脚本的索引。 请参阅编写数组属性的策略。 |

instance_pool_id |

字符串 | 控制工作器节点使用的池(如果还定义了 driver_instance_pool_id,或者对于所有其他群集节点)。 如果为工作器节点使用池,则也必须为驱动程序节点使用池。 隐藏后,从 UI 中删除池选择。 |

driver_instance_pool_id |

字符串 | 如果已指定,则为驱动程序节点配置不同于工作器节点的池。 如果未指定,则会继承 instance_pool_id。 如果为工作器节点使用池,则也必须为驱动程序节点使用池。 如果已隐藏,则会从 UI 中删除驱动程序池选择。 |

is_single_node |

布尔 | 设置为 true 时,计算必须是单个节点。 仅当用户使用 简单表单时,才支持此属性。 |

node_type_id |

字符串 | 隐藏后,从 UI 中删除工作器节点类型选择。 |

worker_node_type_flexibility.alternate_node_type_ids |

字符串 | 指定工作器节点的备用节点类型。 仅支持固定策略。 请参阅 灵活节点类型。 |

num_workers |

可选数值 | 隐藏后,从 UI 中删除辅助角色数目规范。 |

runtime_engine |

字符串 | 确定群集是否使用 Photon。 可能的值为 PHOTON 或 STANDARD。 |

single_user_name |

字符串 | 控制哪些用户或组可以分配到计算资源。 |

spark_conf.* |

可选字符串 | 通过追加配置键名称来控制特定的配置值,例如:spark_conf.spark.executor.memory。 |

spark_env_vars.* |

可选字符串 | 通过追加环境变量来控制特定 Spark 环境变量值,例如:spark_env_vars.<environment variable name>。 |

spark_version |

字符串 | 通过 API 指定的 Spark 映像版本名称(Databricks Runtime)。 还可以使用动态选择 Databricks Runtime 的特殊策略值。 请参阅用于 Databricks Runtime 选择的特殊策略值。 |

use_ml_runtime |

布尔 | 控制是否必须使用 Databricks Runtime 的 ML 版本。 仅当用户使用 简单表单时,才支持此属性。 |

workload_type.clients.jobs |

布尔 | 定义计算资源是否可用于作业。 请参阅防止计算与作业一起使用。 |

workload_type.clients.notebooks |

布尔 | 定义计算资源是否可用于笔记本。 请参阅防止计算与作业一起使用。 |

虚拟属性路径

此表包括策略支持的另外两个合成属性。 如果使用新策略窗体,则可以在 “高级选项 ”部分设置这些属性。

| 属性路径 | 类型 | DESCRIPTION |

|---|---|---|

dbus_per_hour |

数字 | 表示资源每小时可以使用的最大 DBU 数的计算属性,包括驱动程序节点。 此指标是在单个计算级别控制成本的直接方法。 与范围限制配合使用。 |

cluster_type |

字符串 | 表示可以创建的群集类型:

允许或阻止从策略创建指定类型的计算。 如果不允许使用 all-purpose 值,则通用创建计算 UI 中不会显示该策略。 如果不允许使用 job 值,则创建作业计算 UI 中不会显示该策略。 |

灵活的节点类型

灵活的节点类型属性允许指定计算资源在主节点类型不可用时可以使用的备用节点类型。 这些属性具有特殊的策略要求:

- 仅支持固定策略。 不允许所有其他策略类型,在创建策略时将被拒绝。

- 策略中的空字符串映射到备用节点类型的空列表,从而有效地禁用灵活的节点类型。

修复了特定节点类型列表

与使用字符串数组的相应群集 API 字段不同,计算策略属性使用将节点类型的数组编码为逗号分隔列表的单个字符串值。 例如:

{

"worker_node_type_flexibility.alternate_node_type_ids": {

"type": "fixed",

"value": "nodeA,nodeB"

}

}

如果使用群集 API 创建具有分配策略的计算资源,Databricks 建议不要设置 worker_node_type_flexibility 或 driver_node_type_flexibility 字段。 如果确实设置了这些字段,则数组的节点类型和顺序必须与策略的逗号分隔列表完全匹配,否则无法创建计算。 例如,上述策略定义将设置为:

"worker_node_type_flexibility": {

"alternate_node_type_ids": ["nodeA", "nodeB"]

}

禁用灵活节点类型

若要禁用灵活的节点类型,请将该值设置为空字符串。 例如:

{

"worker_node_type_flexibility.alternate_node_type_ids": {

"type": "fixed",

"value": ""

}

}

用于 Databricks Runtime 选择的特殊策略值

spark_version 属性支持根据当前支持的 Databricks Runtime 版本集动态映射到 Databricks Runtime 版本的特殊值。

可以在 spark_version 属性中使用以下值:

-

auto:latest:映射到最新的正式发布 Databricks Runtime 版本。 -

auto:latest-ml:映射到最新的 Databricks Runtime ML 版本。 -

auto:latest-lts:映射到最新的长期支持 (LTS) Databricks Runtime 版本。 -

auto:latest-lts-ml:映射到最新的 LTS Databricks Runtime ML 版本。 -

auto:prev-major:映射到第二新的正式发布 Databricks Runtime 版本。 例如,如果auto:latest为 14.2,则auto:prev-major为 13.3。 -

auto:prev-major-ml:映射到第二新的正式发布 Databricks Runtime ML 版本。 例如,如果auto:latest为 14.2,则auto:prev-major为 13.3。 -

auto:prev-lts:映射到第二新的 LTS Databricks Runtime 版本。 例如,如果auto:latest-lts为 13.3,则auto:prev-lts为 12.2。 -

auto:prev-lts-ml:映射到第二新的 LTS Databricks Runtime ML 版本。 例如,如果auto:latest-lts为 13.3,则auto:prev-lts为 12.2。

注释

使用这些值不会在发布新的运行时版本时自动更新计算。 用户必须显式编辑计算才能更改 Databricks 运行时版本。

支持的策略类型

本部分包含每个可用策略类型的参考。 有两种策略类型:固定策略和限制策略。

固定策略可防止用户对属性进行配置。 固定策略的两种类型为:

限制策略会限制用户的属性配置选项。 限制策略还允许设置默认值并使属性可选。 请参阅其他限制策略字段。

限制策略的选项包括:

固定策略

固定策略将属性限制为指定值。 数值和布尔值以外的属性值必须由字符串表示或必须可转换为字符串。

对于固定策略,还可以通过将 hidden 字段设置为 true 来隐藏 UI 中的属性。

interface FixedPolicy {

type: "fixed";

value: string | number | boolean;

hidden?: boolean;

}

此示例策略修复了 Databricks Runtime 版本,并从用户的 UI 中隐藏字段:

{

"spark_version": { "type": "fixed", "value": "auto:latest-lts", "hidden": true }

}

禁止策略

禁止策略可防止用户配置属性。 禁止策略仅与可选属性兼容。

interface ForbiddenPolicy {

type: "forbidden";

}

此策略禁止将池附加到工作器节点的计算。 由于 driver_instance_pool_id 继承该策略,因此也禁止将池附加到驱动程序节点。

{

"instance_pool_id": { "type": "forbidden" }

}

允许列表策略

允许列表策略指定用户在配置属性时可以选择的值列表。

interface AllowlistPolicy {

type: "allowlist";

values: (string | number | boolean)[];

defaultValue?: string | number | boolean;

isOptional?: boolean;

}

此允许列表示例允许用户在两个 Databricks Runtime 版本之间进行选择:

{

"spark_version": { "type": "allowlist", "values": ["13.3.x-scala2.12", "12.2.x-scala2.12"] }

}

阻止列表策略

阻止列表策略列出不允许的值。 由于值必须完全匹配,因此当属性在值的表示方式上较为宽松时(例如允许前导空格和尾随空格),此策略可能无法达到预期效果。

interface BlocklistPolicy {

type: "blocklist";

values: (string | number | boolean)[];

defaultValue?: string | number | boolean;

isOptional?: boolean;

}

此示例阻止用户选择 7.3.x-scala2.12 作为 Databricks Runtime。

{

"spark_version": { "type": "blocklist", "values": ["7.3.x-scala2.12"] }

}

正则表达式策略

正则表达式策略将可用值限制为与正则表达式匹配的值。 为了安全起见,请确保正则表达式锚定在字符串值的开头和结尾。

interface RegexPolicy {

type: "regex";

pattern: string;

defaultValue?: string | number | boolean;

isOptional?: boolean;

}

此示例限制用户可以选择的 Databricks Runtime 版本:

{

"spark_version": { "type": "regex", "pattern": "13\\.[3456].*" }

}

范围策略

范围策略使用 minValue 和 maxValue 字段将值限制为指定范围。 该值必须是一个十进制数。

数值限制必须表示为双浮点值。 要指示缺少特定的限制,可以省略 minValue 或 maxValue。

interface RangePolicy {

type: "range";

minValue?: number;

maxValue?: number;

defaultValue?: string | number | boolean;

isOptional?: boolean;

}

此示例将工作器的最大数量限制为 10:

{

"num_workers": { "type": "range", "maxValue": 10 }

}

无限制策略

无限制策略用于使属性成为必需或在 UI 中设置默认值。

interface UnlimitedPolicy {

type: "unlimited";

defaultValue?: string | number | boolean;

isOptional?: boolean;

}

此示例将 COST_BUCKET 标记添加到计算:

{

"custom_tags.COST_BUCKET": { "type": "unlimited" }

}

为 Spark 配置变量设置默认值,同时允许省略(删除)该值:

{

"spark_conf.spark.my.conf": { "type": "unlimited", "isOptional": true, "defaultValue": "my_value" }

}

其他限制策略字段

对于限制策略类型,可以指定两个附加字段:

-

defaultValue- 在创建计算 UI 中自动填充的值。 -

isOptional- 属性上的限制策略会自动使其成为必需。 要使属性成为可选项,请将isOptional字段设置为true。

注释

默认值不会自动应用于使用群集 API 创建的计算。 要使用该 API 应用默认值,请将参数 apply_policy_default_values 添加到计算定义并将其设置为 true。

此示例策略为工作器节点的池指定默认值 id1,但将此操作设为可选。 创建计算时,可以选择其他池,也可以不使用任何池。 如果策略中未定义 driver_instance_pool_id 或者在创建计算时,将为工作器节点和驱动程序节点使用同一个池。

{

"instance_pool_id": { "type": "unlimited", "isOptional": true, "defaultValue": "id1" }

}

编写数组属性的策略

可以通过两种方式指定数组属性的策略:

- 对所有数组元素采用一般限制。 这些限制在策略路径中使用

*通配符。 - 对特定索引处的数组元素采用特定限制。 这些限制在路径中使用数字。

注释

灵活的节点类型属性(worker_node_type_flexibility.alternate_node_type_ids 和 driver_node_type_flexibility.alternate_node_type_ids)是群集 API 中的数组类型字段,但它们不遵循此处所述的通配符/索引路径模式。 这些属性需要单个策略规则,该规则将完整列表指定为逗号分隔字符串。 有关详细信息,请参阅 灵活节点类型 。

例如,在数组属性 init_scripts 中,一般路径以 init_scripts.* 开头,特定路径以 init_scripts.<n> 开头,其中 <n> 是数组中的整数索引(从 0 开始)。

可以将一般限制和特定限制结合起来,在这种情况下,一般限制适用于没有特定限制的每个数组元素。 在每种情况下,只有一种政策限制适用。

以下部分展示了使用数组属性的常见示例。

需要特定于包含的条目

如果不指定顺序,则不能要求特定值。 例如:

{

"init_scripts.0.volumes.destination": {

"type": "fixed",

"value": "<required-script-1>"

},

"init_scripts.1.volumes.destination": {

"type": "fixed",

"value": "<required-script-2>"

}

}

需要整个列表的固定值

{

"init_scripts.0.volumes.destination": {

"type": "fixed",

"value": "<required-script-1>"

},

"init_scripts.*.volumes.destination": {

"type": "forbidden"

}

}

完全禁止使用

{

"init_scripts.*.volumes.destination": {

"type": "forbidden"

}

}

允许遵循特定限制的条目

{

"init_scripts.*.volumes.destination": {

"type": "regex",

"pattern": ".*<required-content>.*"

}

}

修复 init 脚本的特定集

如果是 init_scripts 路径,数组可以包含多个结构中的一个,根据用例的不同,可能需要对这些结构的所有可能变体进行处理。 例如,若要要求一组特定的初始化脚本,并且不允许其他版本的任何变体,可以使用以下模式:

{

"init_scripts.0.volumes.destination": {

"type": "fixed",

"value": "<volume-paths>"

},

"init_scripts.1.volumes.destination": {

"type": "fixed",

"value": "<volume-paths>"

},

"init_scripts.*.workspace.destination": {

"type": "forbidden"

},

"init_scripts.*.abfss.destination": {

"type": "forbidden"

},

"init_scripts.*.file.destination": {

"type": "forbidden"

}

}

策略示例

本部分包括可用于创建你自己的策略的策略示例参考。 还可以使用 Azure Databricks 提供的策略系列作为常见策略用例的模板。

常规计算策略

常规用途计算策略,用于指导用户并限制某些功能,同时要求使用标记、限制实例的最大数目并强制执行超时。

{

"instance_pool_id": {

"type": "forbidden",

"hidden": true

},

"spark_version": {

"type": "regex",

"pattern": "12\\.[0-9]+\\.x-scala.*"

},

"node_type_id": {

"type": "allowlist",

"values": ["Standard_L4s", "Standard_L8s", "Standard_L16s"],

"defaultValue": "Standard_L16s_v2"

},

"driver_node_type_id": {

"type": "fixed",

"value": "Standard_L16s_v2",

"hidden": true

},

"autoscale.min_workers": {

"type": "fixed",

"value": 1,

"hidden": true

},

"autoscale.max_workers": {

"type": "range",

"maxValue": 25,

"defaultValue": 5

},

"autotermination_minutes": {

"type": "fixed",

"value": 30,

"hidden": true

},

"custom_tags.team": {

"type": "fixed",

"value": "product"

}

}

定义 Lakeflow Spark 声明性管道计算的限制

注释

在使用策略配置 Lakeflow Spark 声明性管道计算时,Databricks 建议将单个策略同时应用于 default 和 maintenance 计算。

要为管道计算配置策略,请创建一个策略,将 cluster_type 字段设置为 dlt。 以下示例为 Lakeflow Spark 声明性管道计算创建最小策略:

{

"cluster_type": {

"type": "fixed",

"value": "dlt"

},

"num_workers": {

"type": "unlimited",

"defaultValue": 3,

"isOptional": true

},

"node_type_id": {

"type": "unlimited",

"isOptional": true

},

"spark_version": {

"type": "unlimited",

"hidden": true

}

}

简单的中型策略

允许用户使用最小配置创建中型计算。 创建时唯一的必需字段是计算名称,其余为固定字段和隐藏字段。

{

"instance_pool_id": {

"type": "forbidden",

"hidden": true

},

"spark_conf.spark.databricks.cluster.profile": {

"type": "forbidden",

"hidden": true

},

"autoscale.min_workers": {

"type": "fixed",

"value": 1,

"hidden": true

},

"autoscale.max_workers": {

"type": "fixed",

"value": 10,

"hidden": true

},

"autotermination_minutes": {

"type": "fixed",

"value": 60,

"hidden": true

},

"node_type_id": {

"type": "fixed",

"value": "Standard_L8s_v2",

"hidden": true

},

"driver_node_type_id": {

"type": "fixed",

"value": "Standard_L8s_v2",

"hidden": true

},

"spark_version": {

"type": "fixed",

"value": "auto:latest-ml",

"hidden": true

},

"custom_tags.team": {

"type": "fixed",

"value": "product"

}

}

仅作业策略

允许用户创建作业计算来运行作业。 用户无法使用此策略创建通用计算。

{

"cluster_type": {

"type": "fixed",

"value": "job"

},

"dbus_per_hour": {

"type": "range",

"maxValue": 100

},

"instance_pool_id": {

"type": "forbidden",

"hidden": true

},

"num_workers": {

"type": "range",

"minValue": 1

},

"node_type_id": {

"type": "regex",

"pattern": "Standard_[DLS]*[1-6]{1,2}_v[2,3]"

},

"driver_node_type_id": {

"type": "regex",

"pattern": "Standard_[DLS]*[1-6]{1,2}_v[2,3]"

},

"spark_version": {

"type": "unlimited",

"defaultValue": "auto:latest-lts"

},

"custom_tags.team": {

"type": "fixed",

"value": "product"

}

}

外部元存储策略

允许用户创建已附加管理员定义的元存储的计算。 这可用于允许用户创建自己的计算,且无需其他配置。

{

"spark_conf.spark.hadoop.javax.jdo.option.ConnectionURL": {

"type": "fixed",

"value": "jdbc:sqlserver://<jdbc-url>"

},

"spark_conf.spark.hadoop.javax.jdo.option.ConnectionDriverName": {

"type": "fixed",

"value": "com.microsoft.sqlserver.jdbc.SQLServerDriver"

},

"spark_conf.spark.databricks.delta.preview.enabled": {

"type": "fixed",

"value": "true"

},

"spark_conf.spark.hadoop.javax.jdo.option.ConnectionUserName": {

"type": "fixed",

"value": "<metastore-user>"

},

"spark_conf.spark.hadoop.javax.jdo.option.ConnectionPassword": {

"type": "fixed",

"value": "<metastore-password>"

}

}

防止计算与作业一起使用

此策略可防止用户使用计算来运行作业。 用户只能将计算与笔记本一起使用。

{

"workload_type.clients.notebooks": {

"type": "fixed",

"value": true

},

"workload_type.clients.jobs": {

"type": "fixed",

"value": false

}

}

删除自动缩放策略

此策略禁用自动缩放,并允许用户设置给定范围内的工作器数。

{

"num_workers": {

"type": "range",

"maxValue": 25,

"minValue": 1,

"defaultValue": 5

}

}

自定义标记强制实施

要向策略添加计算标记规则,请使用 custom_tags.<tag-name> 属性。

例如,使用此策略的任何用户都需要使用 9999、9921 或 9531 填充 COST_CENTER 标记才能启动计算:

{ "custom_tags.COST_CENTER": { "type": "allowlist", "values": ["9999", "9921", "9531"] } }