适用于 Visual Studio Code 的 Databricks 扩展允许在群集或 Python、R、Scala 或 SQL 代码或笔记本上运行 Python 代码,作为 Azure Databricks 中的作业。

此信息假定你已安装并设置适用于 Visual Studio Code 的 Databricks 扩展。 请参阅安装 Visual Studio Code 的 Databricks 扩展。

注意

请使用 Databricks Connect 从 Visual Studio Code 中调试代码或笔记本。 请参阅使用适用于 Visual Studio Code 的 Databricks 扩展的 Databricks Connect 调试代码以及使用适用于 Visual Studio Code 的 Databricks 扩展通过 Databricks Connect 运行和调试笔记本单元格。

在群集上运行 Python 文件

注意

使用无服务器计算时,此功能不可用。

要使用适用于 Visual Studio Code 的 Databricks 扩展在 Azure Databricks 群集上运行 Python 文件,同时打开扩展和项目:

打开要在群集上运行的 Python 文件。

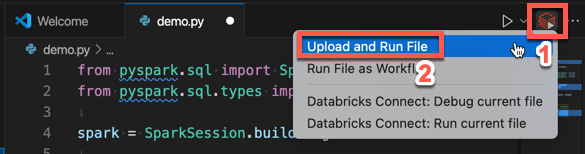

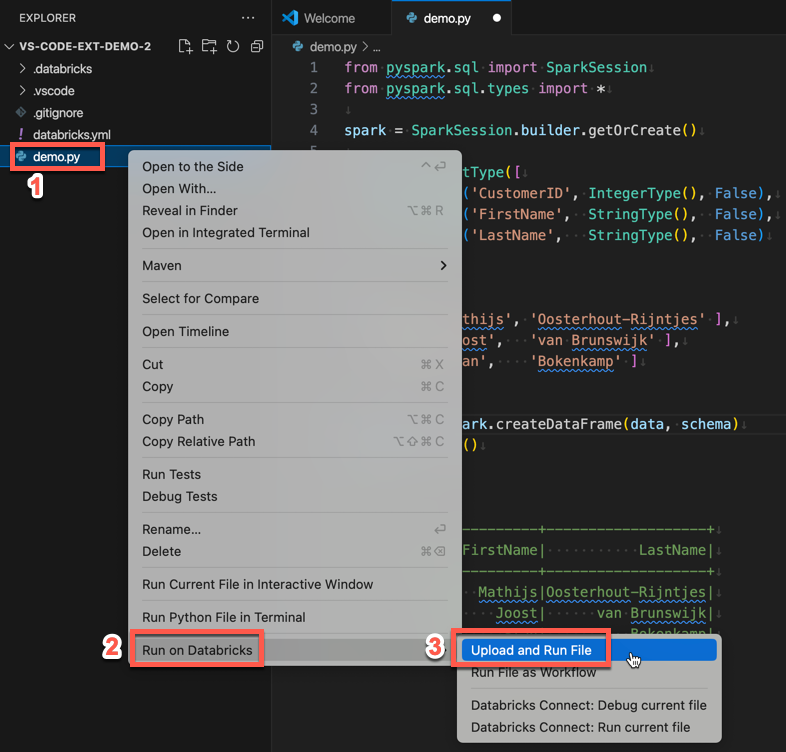

执行下列操作之一:

在文件编辑器的标题栏中,单击“在 Databricks 上运行”图标,然后单击“上传并运行文件”。

在“资源管理器”视图(“视图”>“资源管理器”)中,右键单击该文件,然后从上下文菜单中选择“在 Databricks 上运行”>“上传并运行文件”。

该文件在群集上运行,输出在“调试控制台”(>“查看”“调试控制台”)中可用。

将 Python 文件作为作业运行

要使用适用于 Visual Studio Code 的 Databricks 扩展将 Python 文件作为 Azure Databricks 作业运行,同时打开扩展和项目:

打开要作为作业运行的 Python 文件。

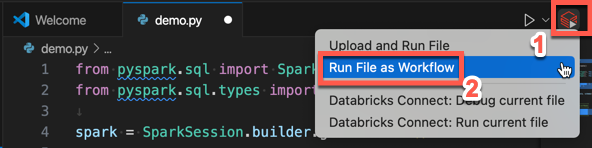

执行下列操作之一:

在文件编辑器的标题栏中,单击“在 Databricks 上运行”图标,然后单击“将文件作为工作流运行”。

在“资源管理器”视图(“视图”>“资源管理器”)中,右键单击该文件,然后从上下文菜单中选择“在 Databricks 上运行”>“将文件作为工作流运行”。

此时会显示一个新的编辑器选项卡,其标题为“Databricks 作业运行”。 该文件将在工作区中作为作业运行,所有输出将显示在新编辑器选项卡的“输出”区域中。

若要查看有关作业运行的信息,请单击新的“Databricks 作业运行”编辑器选项卡中的“任务运行 ID”链接。工作区随即会打开,作业运行详细信息显示在工作区中。

将 Python、R、Scala 或 SQL 笔记本作为作业运行

要使用适用于 Visual Studio Code 的 Databricks 扩展将笔记本作为 Azure Databricks 作业运行,同时打开扩展和项目:

打开要作为作业运行的笔记本。

提示

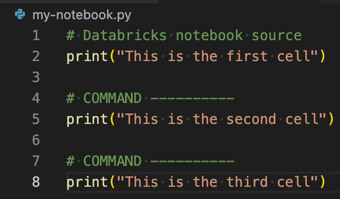

若要将 Python、R、Scala 或 SQL 文件转换为 Azure Databricks 笔记本,请将注释

# Databricks notebook source添加到文件的开头,并在每个单元格之前添加注释# COMMAND ----------。 有关详细信息,请参阅 将文件转换为笔记本。

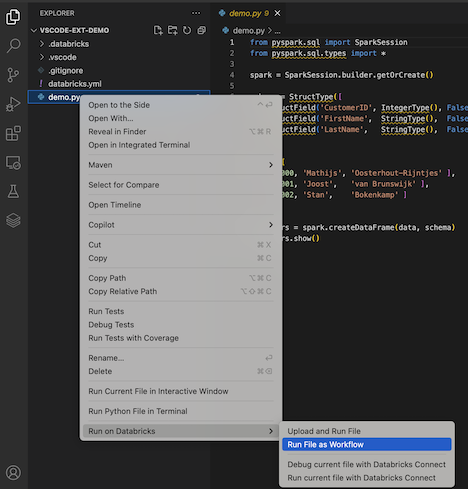

执行下列操作之一:

- 在笔记本文件编辑器的标题栏中,单击“在 Databricks 上运行”图标,然后单击“将文件作为工作流运行”。

- 在“资源管理器”视图(“视图”>“资源管理器”)中,右键单击该笔记本,然后从上下文菜单中选择“在 Databricks 上运行”>“将文件作为工作流运行”。

此时会显示一个新的编辑器选项卡,其标题为“Databricks 作业运行”。 笔记本在工作区中作为作业运行。 笔记本及其输出显示在新编辑器选项卡的“输出”区域中。

若要查看有关作业运行的信息,请单击“Databricks 作业运行”编辑器选项卡中的“任务运行 ID”链接。工作区随即会打开,作业运行详细信息显示在工作区中。

创建自定义运行配置

使用适用于 Visual Studio Code 的 Databricks 扩展的自定义运行配置,可以将自定义参数传递给作业或笔记本,或者为不同的文件创建不同的运行设置。

若要创建自定义运行配置,请在 Visual Studio Code 的主菜单中单击“运行”>“添加配置”。 然后为基于群集的运行配置选择“Databricks”,或者为基于作业的运行配置选择“Databricks: 工作流”。

例如,以下自定义运行配置将修改将文件作为工作流运行启动命令,以将 --prod 参数传递给作业:

{

"version": "0.2.0",

"configurations": [

{

"type": "databricks-workflow",

"request": "launch",

"name": "Run on Databricks as Workflow",

"program": "${file}",

"parameters": {},

"args": ["--prod"]

}

]

}

提示

如果您想使用 Python 配置并利用作为扩展设置一部分的 Databricks Connect 身份验证,请将 "databricks": true 添加到 "type": "python" 配置中。

使用自定义运行配置,您还可以传入命令行参数并运行代码,只需按 F5 即可。 有关详细信息,请参阅 Visual Studio Code 文档中的启动配置。