在本快速入门中,你将使用 Azure Synapse Analytics 通过 Apache Spark 作业定义创建管道。

先决条件

- Azure 订阅:如果没有 Azure 订阅,请在开始前创建一个试用版 Azure 帐户。

- Azure Synapse 工作区:按照快速入门:创建 Synapse 工作区中的说明,使用 Azure 门户创建 Synapse 工作区。

- Apache Spark 作业定义:按照教程:在 Synapse Studio 中创建 Apache Spark 作业定义中的说明操作,在 Synapse 工作区中创建 Apache Spark 作业定义。

导航到 Synapse Studio

创建 Azure Synapse 工作区后,可以通过两种方式打开 Synapse Studio:

- 在 Azure 门户中打开 Synapse 工作区。 在“开始使用”下的“打开 Synapse Studio”卡上选择“打开”。

- 打开 Azure Synapse Analytics 并登录到工作区。

在本快速入门中,我们将以名为“sampletest”的工作区为例。

使用 Apache Spark 作业定义创建管道

管道包含用于执行一组活动的逻辑流。 在本部分中,你将创建一个包含 Apache Spark 作业定义活动的管道。

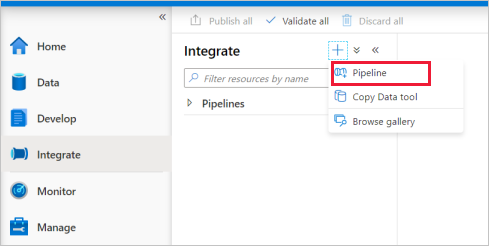

转到“集成”选项卡。选择管道标题旁边的加号图标,然后选择“管道” 。

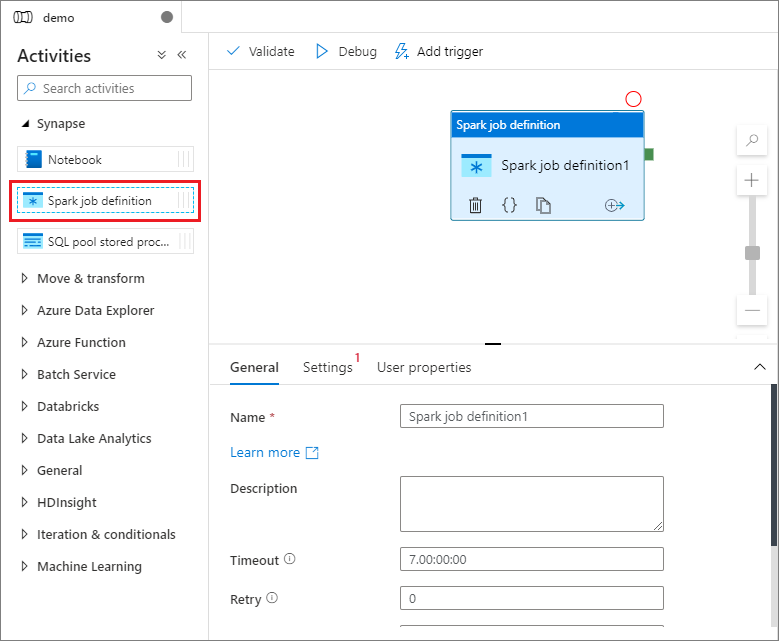

在管道的“属性”设置页中,输入 demo 作为管道的名称 。

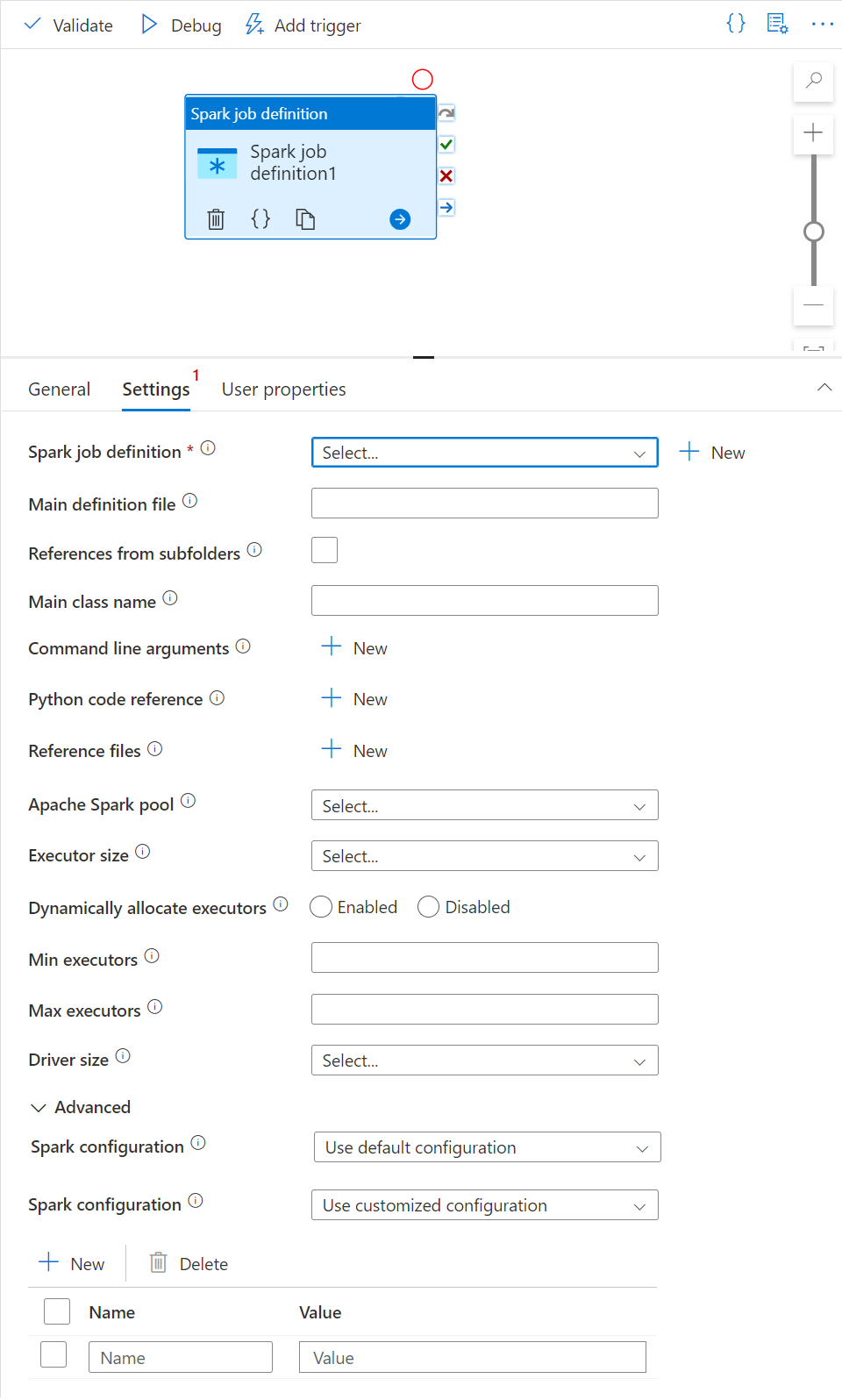

在“活动”窗格中的“Synapse”下,将“Spark 作业定义”拖到管道画布上 。

设置 Apache Spark 作业定义画布

创建 Apache Spark 作业定义后,该作业会自动发送到 Spark 作业定义画布。

常规设置

在画布上选择 Spark 作业定义模块。

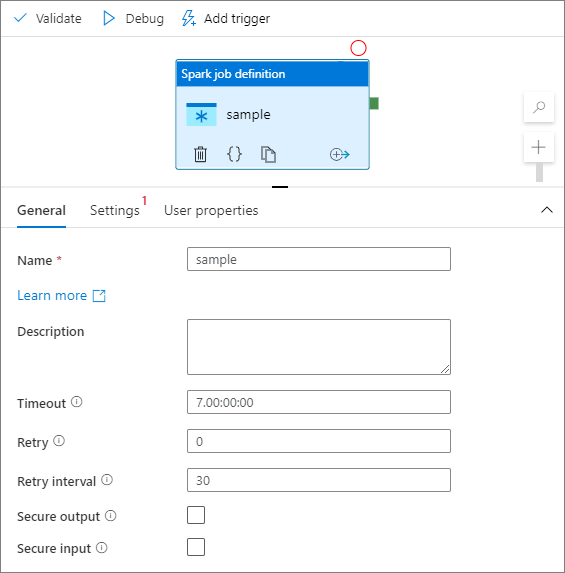

在“常规”选项卡中,输入 sample 作为名称 。

(选项)也可以输入说明。

超时:活动可以运行的最长时间。 默认值为 7 天,这也是允许的最长时间。 格式为 D.HH:MM:SS。

重试:最大重试尝试次数。

重试间隔:两次重试尝试之间的时间,以秒为单位。

安全输出:选中后,将不会在日志记录中捕获活动的输出。

安全输入:选中后,将不会在日志记录中捕获活动的输入。

“设置”选项卡

在此面板上,可以引用要运行的 Spark 作业定义。

展开 Spark 作业定义列表,可以选择现有 Apache Spark 作业定义。 也可通过选择“新建”按钮创建新的 Apache Spark 作业定义,引用要运行的 Spark 作业定义。

(可选)可以填写 Apache Spark 作业定义的信息。 如果以下设置为空,将使用 Spark 作业定义本身的设置来运行;如果以下设置不为空,这些设置将替换 Spark 作业定义本身的设置。

properties 说明 主定义文件 用于作业的主文件。 从存储中选择一个 PY/JAR/ZIP 文件。 可以选择“上传文件”以将文件上传到存储帐户。

示例:abfss://…/path/to/wordcount.jar来自子文件夹的引用 从主定义文件的根文件夹中扫描子文件夹时,这些文件将被添加为引用文件。 将扫描名为“jars”、“pyFiles”、“files”或“archives”的文件夹,文件夹名称区分大小写。 主类名 主定义文件中的完全限定标识符或主类。

示例:WordCount命令行参数 可以通过单击“新建”按钮来添加命令行参数。 应当注意的是,添加命令行参数将替代由 Spark 作业定义定义的命令行参数。

示例:abfss://…/path/to/shakespeare.txtabfss://…/path/to/resultApache Spark 池 可以从列表中选择 Apache Spark 池。 Python 代码参考 用于在主定义文件中引用的其他 Python 代码文件。

它支持将文件(.py、.py3、.zip)传递到“pyFiles”属性。 它将替代 Spark 作业定义中定义的“pyFiles”属性。引用文件 用于在主定义文件中引用的其他文件。 动态分配执行程序 此设置映射到用于 Spark 应用程序执行工具分配的 Spark 配置中的动态分配属性。 最小执行程序数 要在作业的指定 Spark 池中分配的最小执行程序数。 最大执行程序数 要在作业的指定 Spark 池中分配的最大执行程序数。 驱动程序大小 作业的指定 Apache Spark 池中提供的驱动程序要使用的核心数和内存量。 Spark 配置 指定在以下文章中列出的 Spark 配置属性的值:Spark 配置 - 应用程序属性。 用户可以使用默认配置和自定义配置。

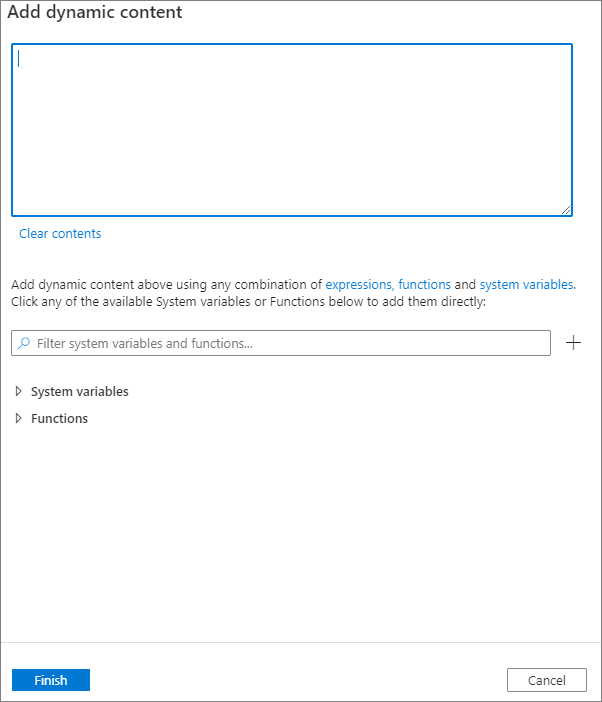

可以通过单击“添加动态内容”按钮或按快捷键 Alt+Shift+D 来添加动态内容。 在“添加动态内容”页面,可以使用表达式、函数和系统变量的任意组合来添加动态内容。

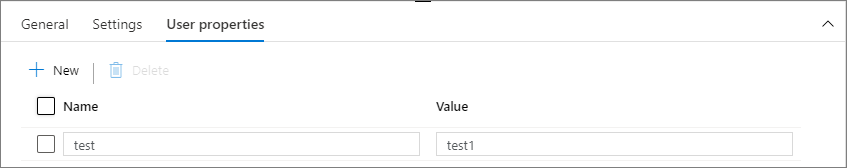

“用户属性”选项卡

可以在此面板中为 Apache Spark 作业定义活动添加属性。

相关内容

请转至下列文章,了解 Azure Synapse Analytics 支持: