工作区包可以是自定义或专用 wheel (Python)、jar (Scala/Java) 或 tar.gz (R) 文件。 可将这些包上传到工作区,然后再将其分配到特定的 Spark 池。

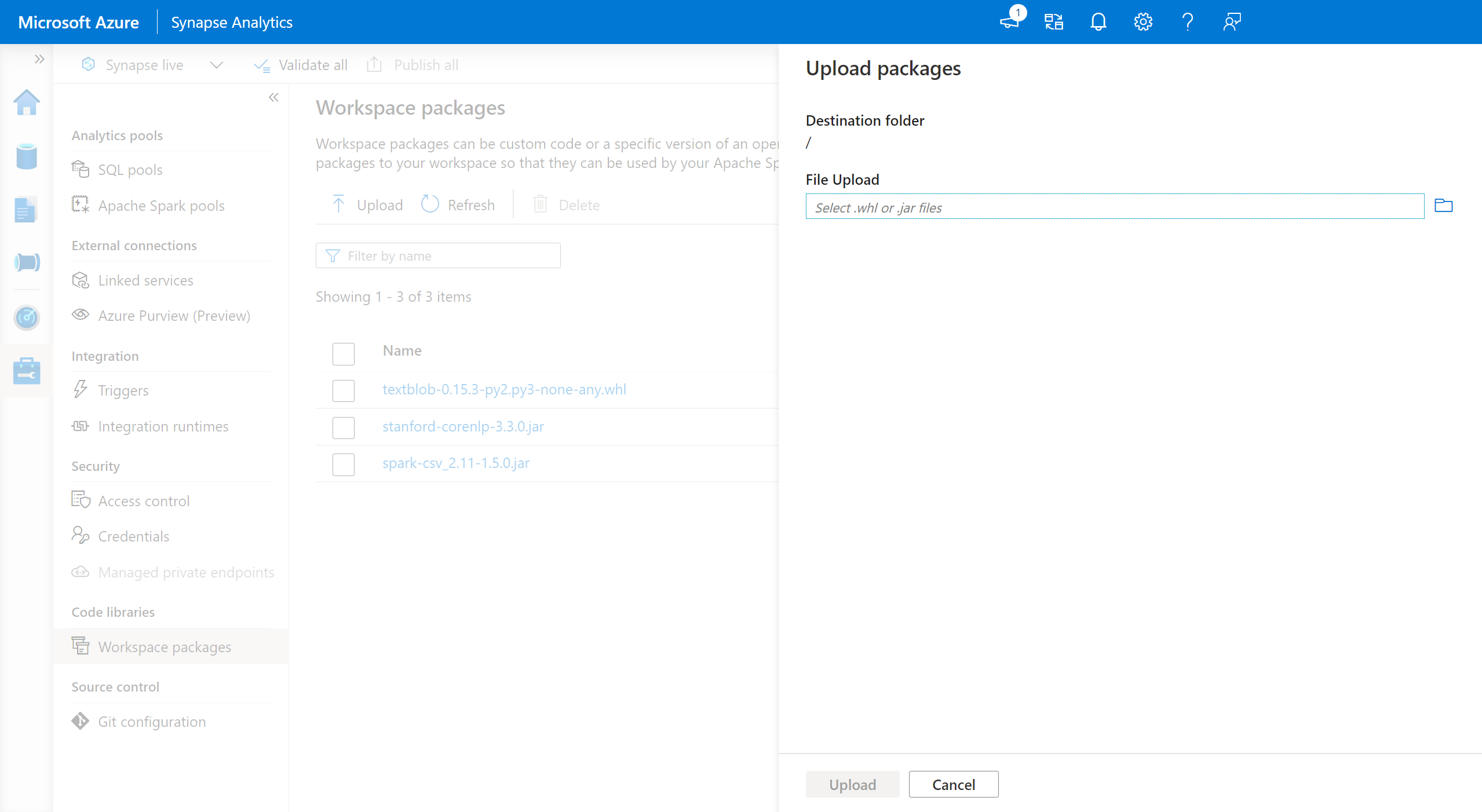

添加工作区包:

- 导航到“管理”>“工作区包”选项卡。

- 使用文件选择器上传文件。

- 将文件上传到 Azure Synapse 工作区后,可将这些包添加到 Apache Spark 池。

警告

在 Azure Synapse 中,Apache Spark 池可以利用自定义库,自定义库可以作为工作区包上传,也可以上传到已知的 Azure Data Lake Storage 路径内。 但在同一 Apache Spark 池内不能同时使用这两种选项。 如果使用两种方法提供包,则只会安装在工作区包列表中指定的 wheel 文件。

在指定 Apache Spark 池中使用工作区包安装包后,就不能再在同一池中使用存储帐户路径来指定包。

注意

建议在工作区中不要有多个同名的包。 如果要使用同一个包的不同版本,则必须删除现有版本并上传新版本。

存储帐户

通过将所有文件上传到与 Synapse 工作区关联的 Azure Data Lake Storage (Gen2) 帐户,可以在 Apache Spark 池上安装自定义包。

应将这些文件上传到存储帐户默认容器中的以下路径:

abfss://<file_system>@<account_name>.dfs.core.chinacloudapi.cn/synapse/workspaces/<workspace_name>/sparkpools/<pool_name>/libraries/python/

警告

- 某些情况下,如果文件路径不存在,则可能需要根据上面的结构创建文件路径。 例如,可能需要

libraries文件夹中添加python文件夹(如果该文件夹不存在)。 - 用于 Apache Spark 3.0 的 Azure Synapse 运行时上不支持这种自定义文件的管理方法。 请参阅工作区包功能以管理自定义文件。

重要

若要使用 Azure DataLake Storage 方法安装自定义库,必须在已链接到 Azure Synapse Analytics 工作区的主 Gen2 存储帐户中拥有“存储 Blob 数据参与者”或“存储 Blob 数据所有者”权限。

后续步骤

- 查看默认库:Apache Spark 版本支持

- 排查库安装错误:排查库错误

- 使用 Azure Data Lake Storage 帐户创建专用的 Conda 通道:Conda 专用通道