使用 Azure 数据工厂或 Synapse Analytics 复制和转换 Microsoft Fabric 湖屋中的数据

适用于: Azure 数据工厂

Azure 数据工厂  Azure Synapse Analytics

Azure Synapse Analytics

提示

试用 Microsoft Fabric 中的数据工厂,这是一种适用于企业的一站式分析解决方案。 Microsoft Fabric 涵盖从数据移动到数据科学、实时分析、商业智能和报告的所有内容。 了解如何免费开始新的试用!

Microsoft Fabric Lakehouse 是一个数据体系结构平台,用于在单个位置存储、管理和分析结构化数据和非结构化数据。 若要在 Microsoft Fabric 中实现跨所有计算引擎的无缝数据访问,请转到湖屋和 Delta 表来了解详细信息。 默认情况下,数据以 V 顺序写入 Lakehouse 表,你可以转到 Delta Lake 表优化和 V 顺序来了解详细信息。

本文概述如何使用复制活动从 Microsoft Fabric 湖屋复制数据或将数据复制到其中,并使用数据流转换 Microsoft Fabric 湖屋中的数据。 有关详细信息,请阅读 Azure 数据工厂或 Azure Synapse Analytics 的简介文章。

支持的功能

以下功能支持此 Microsoft Fabric 湖屋连接器:

| 支持的功能 | IR |

|---|---|

| 复制活动(源/接收器) | ① ② |

| 映射数据流源(源/接收器) | ① |

| Lookup 活动 | ① ② |

| GetMetadata 活动 | ① ② |

| Delete 活动 | ① ② |

① Azure 集成运行时 ② 自承载集成运行时

开始使用

若要使用管道执行复制活动,可以使用以下工具或 SDK 之一:

使用 UI 创建 Microsoft Fabric Lakehouse 链接服务

使用以下步骤在 Azure 门户 UI 中创建 Microsoft Fabric Lakehouse 链接服务。

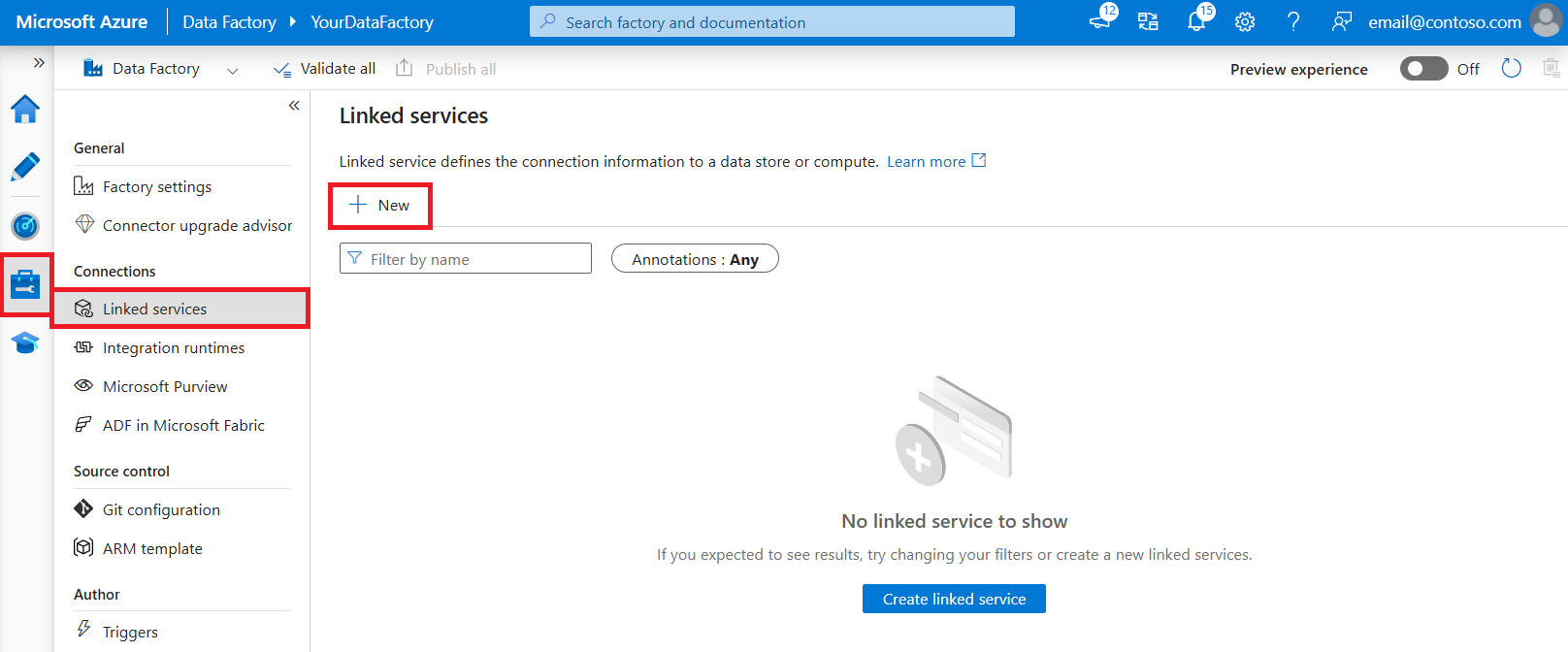

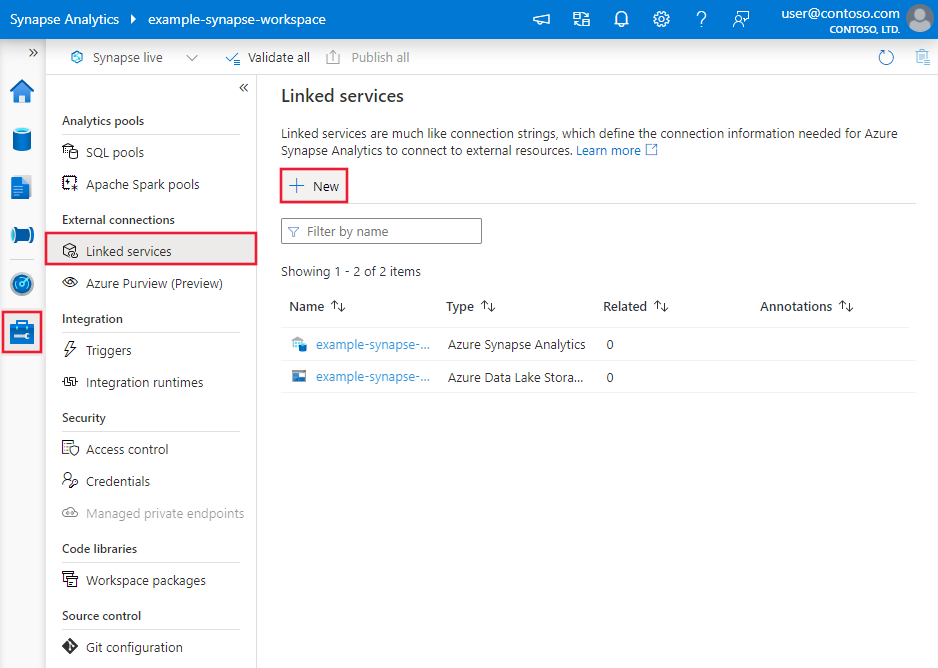

浏览到 Azure 数据工厂或 Synapse 工作区中的“管理”选项卡,并选择“链接服务”,然后选择“新建”:

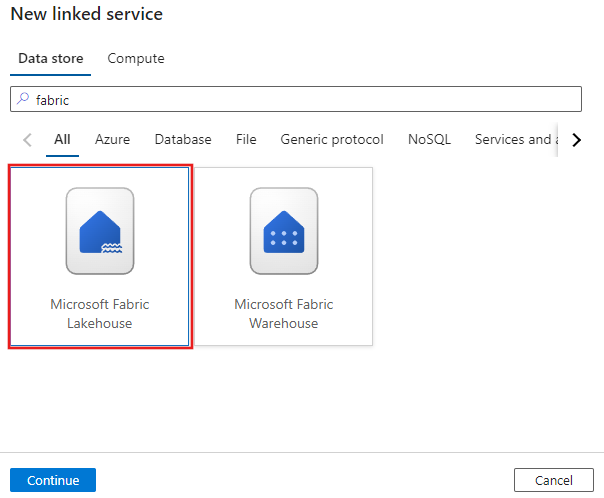

搜索 Microsoft Fabric Lakehouse 并选择连接器。

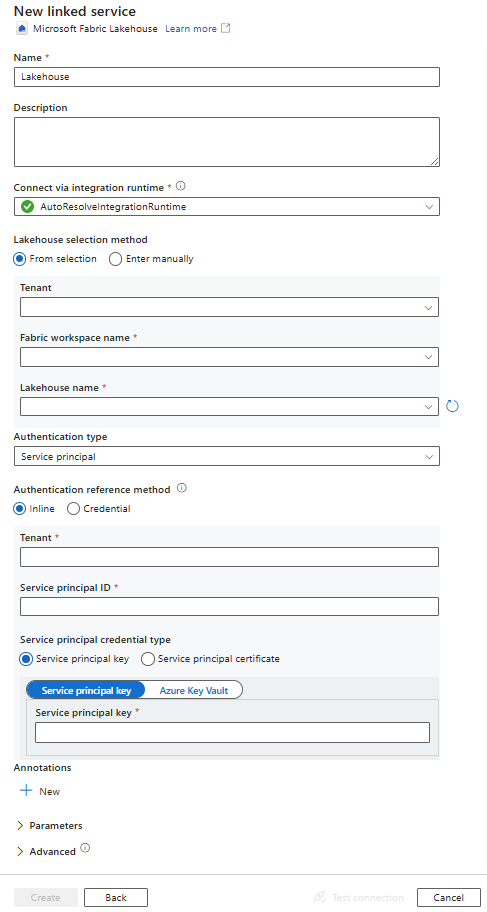

配置服务详细信息、测试连接并创建新的链接服务。

连接器配置详细信息

以下部分提供有关用于定义特定于 Microsoft Fabric Lakehouse 的 Azure 数据工厂实体的属性的详细信息。

链接服务属性

Microsoft Fabric Lakehouse 连接器支持以下身份验证类型。 请参阅相应部分的了解详细信息:

服务主体身份验证

若要使用服务主体身份验证,请按照以下步骤操作。

将应用程序注册到 Microsoft 标识平台并添加客户端密码。 之后,记下以下值,这些值用于定义链接服务:

- 应用程序(客户端)ID,它是链接服务中的服务主体 ID。

- 客户端密码值,它是链接服务中的服务主体密钥。

- 租户 ID

至少向服务主体授予 Microsoft Fabric 工作区中的“参与者”角色。 执行以下步骤:

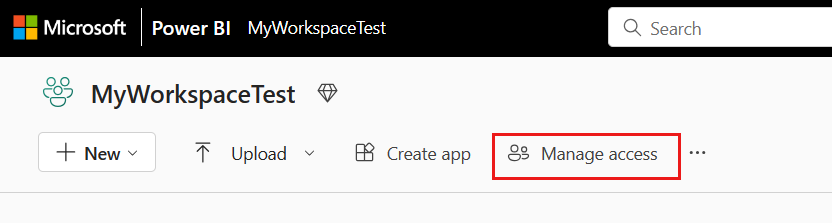

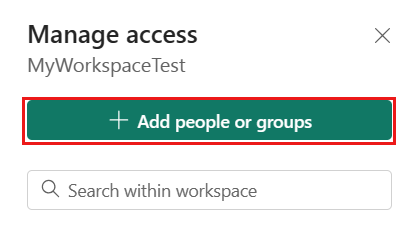

转到 Microsoft Fabric 工作区,选择顶部栏上的“管理访问”。 然后选择“添加人员或组”。

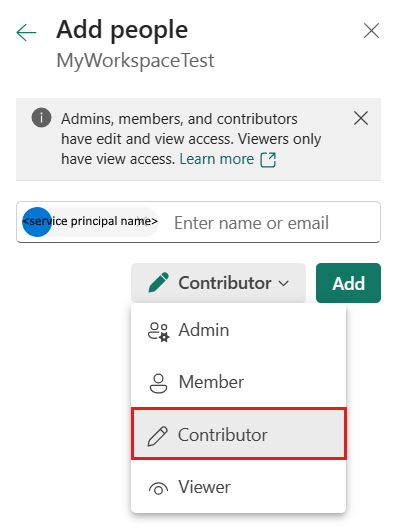

在“添加人员”窗格中,输入服务主体名称,然后从下拉列表中选择服务主体。

注意

除非 Power BI 租户设置启用对 Fabric API 的服务主体访问权限,否则服务主体不会显示在“添加人员”列表中。

将角色指定为“参与者”或更高级别角色(管理员、成员),然后选择“添加”。

服务主体显示在“管理访问”窗格上。

链接服务支持以下属性:

| 属性 | 描述 | 必需 |

|---|---|---|

| type | type 属性必须设置为 Lakehouse。 | 是 |

| workspaceId | Microsoft Fabric 工作区 ID。 | 是 |

| artifactId | Microsoft Fabric Lakehouse 对象 ID。 | 是 |

| tenant | 指定应用程序的租户信息(域名或租户 ID)。 将鼠标悬停在 Azure 门户右上角进行检索。 | 是 |

| servicePrincipalId | 指定应用程序的客户端 ID。 | 是 |

| servicePrincipalCredentialType | 要用于服务主体身份验证的凭据类型。 允许的值为“ServicePrincipalKey”和“ServicePrincipalCert”。 | 是 |

| servicePrincipalCredential | 服务主体凭据。 使用“ServicePrincipalKey”作为凭据类型时,请指定应用程序的客户端密码值。 将此字段标记为 SecureString 以安全地存储它,或引用存储在 Azure Key Vault 中的机密。 当使用 ServicePrincipalCert 作为凭据时,请引用 Azure Key Vault 中的证书并确保证书内容类型为 PKCS #12。 |

是 |

| connectVia | 用于连接到数据存储的集成运行时。 可使用 Azure Integration Runtime 或自承载集成运行时(如果数据存储位于专用网络)。 如果未指定,则使用默认 Azure Integration Runtime。 | 否 |

示例:使用服务主体密钥身份验证

也可以将服务主体密钥存储在 Azure Key Vault 中。

{

"name": "MicrosoftFabricLakehouseLinkedService",

"properties": {

"type": "Lakehouse",

"typeProperties": {

"workspaceId": "<Microsoft Fabric workspace ID>",

"artifactId": "<Microsoft Fabric Lakehouse object ID>",

"tenant": "<tenant info, e.g. *.partner.onmschina.cn>",

"servicePrincipalId": "<service principal id>",

"servicePrincipalCredentialType": "ServicePrincipalKey",

"servicePrincipalCredential": {

"type": "SecureString",

"value": "<service principal key>"

}

},

"connectVia": {

"referenceName": "<name of Integration Runtime>",

"type": "IntegrationRuntimeReference"

}

}

}

数据集属性

Microsoft Fabric 湖屋连接器支持两种类型的数据集:Microsoft Fabric 湖屋文件数据集和 Microsoft Fabric 湖屋表数据集。 有关详细信息,请参阅相应部分。

有关可用于定义数据集的各个部分和属性的完整列表,请参阅数据集。

Microsoft Fabric 湖屋文件数据集

Microsoft Fabric 湖屋连接器支持以下文件格式。 请参阅每一篇介绍基于格式的设置的文章。

基于格式的 Microsoft Fabric 湖屋文件数据集中的 location 设置下支持属性:

| properties | 描述 | 必需 |

|---|---|---|

| type | 数据集中 location 下的 type 属性必须设置为 LakehouseLocation。 |

是 |

| folderPath | 文件夹路径。 若要使用通配符来筛选文件夹,请跳过此设置,并在活动源设置中指定它。 | 否 |

| fileName | 给定 folderPath 下的文件名。 若要使用通配符来筛选文件,请跳过此设置,并在活动源设置中指定它。 | 否 |

示例:

{

"name": "DelimitedTextDataset",

"properties": {

"type": "DelimitedText",

"linkedServiceName": {

"referenceName": "<Microsoft Fabric Lakehouse linked service name>",

"type": "LinkedServiceReference"

},

"typeProperties": {

"location": {

"type": "LakehouseLocation",

"fileName": "<file name>",

"folderPath": "<folder name>"

},

"columnDelimiter": ",",

"compressionCodec": "gzip",

"escapeChar": "\\",

"firstRowAsHeader": true,

"quoteChar": "\""

},

"schema": [ < physical schema, optional, auto retrieved during authoring > ]

}

}

Microsoft Fabric 湖屋表数据集

Microsoft Fabric Lakehouse 表数据集支持以下属性:

| properties | 描述 | 必需 |

|---|---|---|

| type | 数据集的 type 属性必须设置为 LakehouseTable。 | 是 |

| schema | 架构的名称。 如果未指定,默认值为 dbo。 |

否 |

| table | 表的名称。 | 是 |

示例:

{

"name": "LakehouseTableDataset",

"properties": {

"type": "LakehouseTable",

"linkedServiceName": {

"referenceName": "<Microsoft Fabric Lakehouse linked service name>",

"type": "LinkedServiceReference"

},

"typeProperties": {

"schema": "<schema_name>",

"table": "<table_name>"

},

"schema": [< physical schema, optional, retrievable during authoring >]

}

}

复制活动属性

Microsoft Fabric 湖屋文件数据集和 Microsoft Fabric 湖屋表数据集的复制活动属性不同。 有关详细信息,请参阅相应部分。

要完整了解可供活动定义使用的各个部分和属性,请参阅复制活动配置和管道和活动。

复制活动中的 Microsoft Fabric 湖屋文件

若要在复制活动中将 Microsoft Fabric 湖屋文件数据集类型用作源或接收器,请转到以下部分了解详细的配置。

Microsoft Fabric Lakehouse Files 作为源类型

Microsoft Fabric 湖屋连接器支持以下文件格式。 请参阅每一篇介绍基于格式的设置的文章。

可通过多种选项,使用 Microsoft Fabric 湖屋文件数据集从 Microsoft Fabric 湖屋复制数据:

- 从数据集中指定的给定路径复制。

- 有关针对文件夹路径或文件名的通配符筛选器,请参阅

wildcardFolderPath和wildcardFileName。 - 将给定文本文件中定义的文件复制为文件集(请参阅

fileListPath)。

使用 Microsoft Fabric 湖屋文件数据集时,可在基于格式的复制源中的 storeSettings 设置下找到以下属性:

| properties | 描述 | 必需 |

|---|---|---|

| type | storeSettings 下的 type 属性必须设置为 LakehouseReadSettings。 |

是 |

| 找到要复制的文件: | ||

| 选项 1:静态路径 |

从数据集中指定的文件夹/文件路径复制。 若要复制文件夹中的所有文件,请另外将 wildcardFileName 指定为 *。 |

|

| 选项 2:通配符 - wildcardFolderPath |

带有通配符的文件夹路径,用于筛选源文件夹。 允许的通配符为: *(匹配零个或更多个字符)和 ?(匹配零个或单个字符);如果实际文件夹名称中包含通配符或此转义字符,请使用 ^ 进行转义。 请参阅文件夹和文件筛选器示例中的更多示例。 |

否 |

| 选项 2:通配符 - wildcardFileName |

给定 folderPath/wildcardFolderPath 下带有通配符的文件名,用于筛选源文件。 允许的通配符为: *(匹配零个或更多个字符)和 ?(匹配零个或单个字符);如果实际文件名中包含通配符或此转义字符,请使用 ^ 进行转义。 请参阅文件夹和文件筛选器示例中的更多示例。 |

是 |

| 选项 3:文件列表 - fileListPath |

指明复制给定文件集。 指向包含要复制的文件列表的文本文件,每行一个文件(即数据集中所配置路径的相对路径)。 使用此选项时,请不要在数据集中指定文件名。 请参阅文件列表示例中的更多示例。 |

否 |

| 其他设置: | ||

| recursive | 指示是要从子文件夹中以递归方式读取数据,还是只从指定的文件夹中读取数据。 当 recursive 设置为 true 且接收器是基于文件的存储时,将不会在接收器上复制或创建空的文件夹或子文件夹。 允许的值为 true(默认值)和 false。 如果配置 fileListPath,则此属性不适用。 |

否 |

| deleteFilesAfterCompletion | 指示是否会在二进制文件成功移到目标存储后将其从源存储中删除。 文件删除按文件进行。因此,当复制活动失败时,你会看到一些文件已经复制到目标并从源中删除,而另一些文件仍保留在源存储中。 此属性仅在二进制文件复制方案中有效。 默认值:false。 |

否 |

| modifiedDatetimeStart | 基于属性“上次修改时间”的文件筛选器。 如果文件的上次修改时间大于或等于 modifiedDatetimeStart 并且小于 modifiedDatetimeEnd,将选择这些文件。 该时间应用于 UTC 时区,格式为“2018-12-01T05:00:00Z”。 属性可以为 NULL,这意味着不向数据集应用任何文件特性筛选器。 如果 modifiedDatetimeStart 具有日期/时间值,但 modifiedDatetimeEnd 为 NULL,则意味着将选中“上次修改时间”属性大于或等于该日期/时间值的文件。 如果 modifiedDatetimeEnd 具有日期/时间值,但 modifiedDatetimeStart 为 NULL,则意味着将选中“上次修改时间”属性小于该日期/时间值的文件。如果配置 fileListPath,则此属性不适用。 |

否 |

| modifiedDatetimeEnd | 同上。 | 否 |

| enablePartitionDiscovery | 对于已分区的文件,请指定是否从文件路径分析分区,并将它们添加为另外的源列。 允许的值为 false(默认)和 true 。 |

否 |

| partitionRootPath | 启用分区发现时,请指定绝对根路径,以便将已分区文件夹读取为数据列。 如果未指定,则默认为 - 在数据集或源的文件列表中使用文件路径时,分区根路径是在数据集中配置的路径。 - 使用通配符文件夹筛选器时,分区根路径是第一个通配符前面的子路径。 例如,假设你将数据集中的路径配置为“root/folder/year=2020/month=08/day=27”: - 如果将分区根路径指定为“root/folder/year=2020”,则除了文件内的列外,复制活动还会生成另外两列 month 和 day,其值分别为“08”和“27”。- 如果未指定分区根路径,不会生成额外的列。 |

否 |

| maxConcurrentConnections | 活动运行期间与数据存储建立的并发连接的上限。 仅在要限制并发连接时指定一个值。 | 否 |

示例:

"activities": [

{

"name": "CopyFromLakehouseFiles",

"type": "Copy",

"inputs": [

{

"referenceName": "<Delimited text input dataset name>",

"type": "DatasetReference"

}

],

"outputs": [

{

"referenceName": "<output dataset name>",

"type": "DatasetReference"

}

],

"typeProperties": {

"source": {

"type": "DelimitedTextSource",

"storeSettings": {

"type": "LakehouseReadSettings",

"recursive": true,

"enablePartitionDiscovery": false

},

"formatSettings": {

"type": "DelimitedTextReadSettings"

}

},

"sink": {

"type": "<sink type>"

}

}

}

]

Microsoft Fabric Lakehouse Files 作为接收器类型

Microsoft Fabric 湖屋连接器支持以下文件格式。 请参阅每一篇介绍基于格式的设置的文章。

使用 Microsoft Fabric 湖屋文件数据集时,可在基于格式的复制接收器中的 storeSettings 设置下找到以下属性:

| properties | 描述 | 必需 |

|---|---|---|

| type | storeSettings 下的 type 属性必须设置为 LakehouseWriteSettings。 |

是 |

| copyBehavior | 定义以基于文件的数据存储中的文件为源时的复制行为。 允许值包括: - PreserveHierarchy(默认):将文件层次结构保留到目标文件夹中。 指向源文件夹的源文件相对路径与指向目标文件夹的目标文件相对路径相同。 - FlattenHierarchy:源文件夹中的所有文件都位于目标文件夹的第一级中。 目标文件具有自动生成的名称。 - MergeFiles:将源文件夹中的所有文件合并到一个文件中。 如果指定了文件名,则合并文件的名称为指定名称。 否则,它是自动生成的文件名。 |

否 |

| blockSizeInMB | 指定用于将数据写入到 Microsoft Fabric 湖屋的块大小(以 MB 为单位)。 详细了解块 Blob。 允许的值介于 4 MB 到 100 MB 之间。 默认情况下,ADF 会根据源存储类型和数据自动确定块大小。 对于复制到 Microsoft Fabric 湖屋的非二进制副本,默认块大小为 100 MB,这样最多能容纳约 4.75 TB 数据。 当数据不太大时,该大小可能不是最佳选择,尤其是在网络较差的情况下使用自承载集成运行时会导致操作超时或性能问题。 可以显式指定块大小,同时确保 blockSizeInMB*50000 的大小足够用来存储数据,否则复制活动运行失败。 |

否 |

| maxConcurrentConnections | 活动运行期间与数据存储建立的并发连接的上限。 仅在要限制并发连接时指定一个值。 | 否 |

| metadata | 在复制到接收器时设置自定义元数据。 metadata 数组下的每个对象都表示一个额外的列。 name 定义元数据键名称,value 表示该键的数据值。 如果使用了保留属性功能,则指定的元数据会与源文件元数据联合,或者会被其覆盖。允许的数据值为: - $$LASTMODIFIED:保留变量指示存储源文件的上次修改时间。 仅适用于二进制格式的基于文件的源。- 表达式 - 静态值 |

否 |

示例:

"activities": [

{

"name": "CopyToLakehouseFiles",

"type": "Copy",

"inputs": [

{

"referenceName": "<input dataset name>",

"type": "DatasetReference"

}

],

"outputs": [

{

"referenceName": "<Parquet output dataset name>",

"type": "DatasetReference"

}

],

"typeProperties": {

"source": {

"type": "<source type>"

},

"sink": {

"type": "ParquetSink",

"storeSettings": {

"type": "LakehouseWriteSettings",

"copyBehavior": "PreserveHierarchy",

"metadata": [

{

"name": "testKey1",

"value": "value1"

},

{

"name": "testKey2",

"value": "value2"

}

]

},

"formatSettings": {

"type": "ParquetWriteSettings"

}

}

}

}

]

文件夹和文件筛选器示例

本部分介绍使用通配符筛选器生成文件夹路径和文件名的行为。

| folderPath | fileName | recursive | 源文件夹结构和筛选器结果(用粗体表示的文件已检索) |

|---|---|---|---|

Folder* |

(为空,使用默认值) | false | FolderA File1.csv File2.json Subfolder1 File3.csv File4.json File5.csv AnotherFolderB File6.csv |

Folder* |

(为空,使用默认值) | true | FolderA File1.csv File2.json Subfolder1 File3.csv File4.json File5.csv AnotherFolderB File6.csv |

Folder* |

*.csv |

false | FolderA File1.csv File2.json Subfolder1 File3.csv File4.json File5.csv AnotherFolderB File6.csv |

Folder* |

*.csv |

是 | FolderA File1.csv File2.json Subfolder1 File3.csv File4.json File5.csv AnotherFolderB File6.csv |

文件列表示例

本部分介绍了在复制活动源中使用文件列表路径时的结果行为。

假设有以下源文件夹结构,并且要复制加粗显示的文件:

| 示例源结构 | FileListToCopy.txt 中的内容 | ADF 配置 |

|---|---|---|

| filesystem FolderA File1.csv File2.json Subfolder1 File3.csv File4.json File5.csv 元数据 FileListToCopy.txt |

File1.csv Subfolder1/File3.csv Subfolder1/File5.csv |

在数据集中: - 文件夹路径: FolderA在复制活动源中: - 文件列表路径: Metadata/FileListToCopy.txt 文件列表路径指向同一数据存储中的文本文件,其中包含要复制的文件列表,每行一个文件,以及在数据集中配置的路径的相对路径。 |

一些 recursive 和 copyBehavior 示例

本节介绍了将 recursive 和 copyBehavior 值进行不同组合所产生的复制操作行为。

| recursive | copyBehavior | 源文件夹结构 | 生成目标 |

|---|---|---|---|

| true | preserveHierarchy | Folder1 文件 1 文件 2 Subfolder1 File3 File4 File5 |

使用与源相同的结构创建目标 Folder1: Folder1 文件 1 文件 2 Subfolder1 File3 File4 File5 |

| 是 | flattenHierarchy | Folder1 文件 1 文件 2 Subfolder1 File3 File4 File5 |

使用以下结构创建目标 Folder1: Folder1 File1 的自动生成的名称 File2 的自动生成的名称 File3 的自动生成的名称 File4 的自动生成的名称 File5 的自动生成的名称 |

| 是 | mergeFiles | Folder1 文件 1 文件 2 Subfolder1 File3 File4 File5 |

使用以下结构创建目标 Folder1: Folder1 File1 + File2 + File3 + File4 + File5 的内容将合并到一个文件中,且自动生成文件名。 |

| false | preserveHierarchy | Folder1 文件 1 文件 2 Subfolder1 File3 File4 File5 |

使用以下结构创建目标 Folder1: Folder1 文件 1 文件 2 没有选取包含 File3、File4 和 File5 的 Subfolder1。 |

| false | flattenHierarchy | Folder1 文件 1 文件 2 Subfolder1 File3 File4 File5 |

使用以下结构创建目标 Folder1: Folder1 File1 的自动生成的名称 File2 的自动生成的名称 没有选取包含 File3、File4 和 File5 的 Subfolder1。 |

| false | mergeFiles | Folder1 文件 1 文件 2 Subfolder1 File3 File4 File5 |

使用以下结构创建目标 Folder1: Folder1 File1 + File2 的内容将合并到一个文件中,且自动生成文件名。 File1 的自动生成的名称 没有选取包含 File3、File4 和 File5 的 Subfolder1。 |

复制活动中的 Microsoft Fabric 湖屋表

若要在复制活动中将 Microsoft Fabric 湖屋表数据集用作源或接收器数据集,请转到以下部分了解详细的配置。

Microsoft Fabric Lakehouse 表作为源类型

若要使用 Microsoft Fabric 湖屋表数据集从 Microsoft Fabric 湖屋复制数据,请将复制活动源中的 type 属性设置为 LakehouseTableSource。 复制活动的“源”部分支持以下属性:

| 属性 | 描述 | 必需 |

|---|---|---|

| type | 复制活动源的 type 属性必须设置为 LakehouseTableSource。 | 是 |

| timestampAsOf | 用于查询较旧快照的时间戳。 | 否 |

| versionAsOf | 要查询较旧快照的版本。 | 否 |

示例:

"activities":[

{

"name": "CopyFromLakehouseTable",

"type": "Copy",

"inputs": [

{

"referenceName": "<Microsoft Fabric Lakehouse Table input dataset name>",

"type": "DatasetReference"

}

],

"outputs": [

{

"referenceName": "<output dataset name>",

"type": "DatasetReference"

}

],

"typeProperties": {

"source": {

"type": "LakehouseTableSource",

"timestampAsOf": "2023-09-23T00:00:00.000Z",

"versionAsOf": 2

},

"sink": {

"type": "<sink type>"

}

}

}

]

Microsoft Fabric Lakehouse 表作为接收器类型

若要使用 Microsoft Fabric 湖屋表数据集将数据复制到 Microsoft Fabric 湖屋,请将复制活动接收器中的 type 属性设置为 LakehouseTableSink。 复制活动的 sink 节支持以下属性:

| 属性 | 描述 | 必需 |

|---|---|---|

| type | 复制活动源的 type 属性必须设置为 LakehouseTableSink。 | 是 |

注意

默认情况下,数据以 V 顺序写入 Lakehouse 表。 有关详细信息,请转到 Delta Lake 表优化和 V 顺序。

示例:

"activities":[

{

"name": "CopyToLakehouseTable",

"type": "Copy",

"inputs": [

{

"referenceName": "<input dataset name>",

"type": "DatasetReference"

}

],

"outputs": [

{

"referenceName": "<Microsoft Fabric Lakehouse Table output dataset name>",

"type": "DatasetReference"

}

],

"typeProperties": {

"source": {

"type": "<source type>"

},

"sink": {

"type": "LakehouseTableSink",

"tableActionOption ": "Append"

}

}

}

]

映射数据流属性

在映射数据流的过程中转换数据时,可在 Microsoft Fabric 湖屋中读取文件或表,还可向文件或表写入内容。 有关详细信息,请参阅相应部分。

映射数据流中的 Microsoft Fabric 湖屋文件

若要在映射数据流中将 Microsoft Fabric 湖屋文件数据集用作源或接收器数据集,请转到以下部分了解详细的配置。

Microsoft Fabric Lakehouse 文件作为源或接收器类型

Microsoft Fabric 湖屋连接器支持以下文件格式。 请参阅每一篇介绍基于格式的设置的文章。

若要在内联数据集类型中使用基于 Fabric Lakehouse 文件的连接器,需要为数据选择正确的内联数据集类型。 可以根据数据格式使用 DelimitedText、Avro、JSON、ORC 或 Parquet。

映射数据流中的 Microsoft Fabric 湖屋表

若要在映射数据流中将 Microsoft Fabric 湖屋表数据集用作源或接收器数据集,请转到以下部分了解详细的配置。

Microsoft Fabric Lakehouse 表作为源类型

源选项下没有可配置的属性。

注意

目前不提供对湖屋表源的 CDC 支持。

Microsoft Fabric Lakehouse 表作为接收器类型

映射数据流的“接收器”部分支持以下属性:

| 名称 | 说明 | 必需 | 允许的值 | 数据流脚本属性 |

|---|---|---|---|---|

| Update 方法 | 单独选择“允许插入”或写入新的增量表时,目标会接收所有传入行,而不考虑设置的行策略。 如果你的数据包含其他行策略的行,则需要使用前面的筛选器转换来排除它们。 选择所有更新方法时,会执行合并,根据使用前面的更改行转换设置的行策略插入/删除/更新行。 |

是 | true 或 false |

insertable deletable upsertable 可更新 |

| 优化写入 | 通过优化 Spark 执行程序中的内部随机选择,使写入操作实现更高的吞吐量。 因此,你可能会注意到分区和文件更少,但大小更大 | 否 | true 或 false |

optimizedWrite: true |

| 自动压缩 | 完成任何写入操作后,Spark 会自动执行 OPTIMIZE 命令来重新组织数据,在必要时生成更多分区,以便在将来获得更好的读取性能 |

否 | true 或 false |

autoCompact: true |

| 合并架构 | “合并架构”选项允许架构演变,即当前传入流中有、但目标 Delta 表中没有的所有列会自动添加到架构中。 所有更新方法都支持此选项。 | 否 | true 或 false |

mergeSchema: true |

示例:Microsoft Fabric Lakehouse 表接收器

sink(allowSchemaDrift: true,

validateSchema: false,

input(

CustomerID as string,

NameStyle as string,

Title as string,

FirstName as string,

MiddleName as string,

LastName as string,

Suffix as string,

CompanyName as string,

SalesPerson as string,

EmailAddress as string,

Phone as string,

PasswordHash as string,

PasswordSalt as string,

rowguid as string,

ModifiedDate as string

),

deletable:false,

insertable:true,

updateable:false,

upsertable:false,

optimizedWrite: true,

mergeSchema: true,

autoCompact: true,

skipDuplicateMapInputs: true,

skipDuplicateMapOutputs: true) ~> CustomerTable

对于内联数据集类型中基于 Fabric Lakehouse 表的连接器,只需使用 Delta 作为数据集类型。 这样,就可以从 Fabric Lakehouse 表读取和写入数据。

查找活动属性

若要了解有关属性的详细信息,请查看 Lookup 活动。

GetMetadata 活动属性

若要了解有关属性的详细信息,请查看 GetMetadata 活动

Delete 活动属性

若要详细了解这些属性,请查看 Delete 活动

相关内容

有关复制活动支持作为源和接收器的数据存储的列表,请参阅受支持的数据存储。